Репликация данных

Нужные данные в нужном месте в нужное время

Цели репликации данных

Как правило, по мере расширения любого предприятия быстро возникает необходимость иметь несколько центров обработки данных. Обычно оптимальным решением таких задач, как быстрое реагирование на запросы клиентов, обеспечение надежной «цепочки поставок» и взаимодействия между сотрудниками, является размещение информации там, где она используется. Следовательно, необходимо обеспечить доступность одной и той же информации в нескольких местах (офисах), возможно, находящихся далеко друг от друга. Чтобы одна и та же информация была доступна в нескольких офисах организации, необходимо реплицировать (публиковать) данные в эти офисы. Прайс-листы, спецификации продукции, Web-страницы и другие подобные данные зачастую требуется реплицировать во все офисы предприятия. Очевидно, что для нормального функционирования организации большое значение имеет идентичность этих данных в любом из ее офисов. Поэтому любые изменения данных должны вноситься одновременно (быть синхронизированными) во всех офисах.

Репликация данных также часто проводится с целью извлечения информации для ее анализа

(mining). По мере развития предприятия объем накопленных данных о его деятельности (исторических данных) неизбежно растет. Исторические данные можно хранить в хранилищах данных и извлекать их для анализа тенденций, результаты которого можно использовать при планировании и для других целей. Хотя извлечение данных для анализа дает очень полезные результаты, оно требует выполнения огромного количества операций вводавывода. Как правило, извлечение онлайновых данных предприятия оказывает сильное влияние на выполнение текущих операций. Чтобы избежать этого неблагоприятного влияния, онлайновые данные можно реплицировать на отдельный сервер, служащий хранилищем данных. Данные, помещенные в такое хранилище, можно затем извлекать для анализа, не прерывая выполнение операций над рабочей копией данных.

Третьей, и едва ли не самой важной, причиной репликации данных является обеспечение возможности их восстановления после аварий. По мере расширения предприятия экономические и социальные последствия события, приводящего к выходу из строя центра данных, становятся все более тяжелыми. Очевидно, что для нормального функционирования предприятия необходимо обеспечить быстрое восстановление его работоспособности после пожара, наводнения, акта вандализма, отказа электрической сети, сбоя в программном обеспечении и других событий, которые могут полностью вывести из строя его центр данных. Наличие актуальной копии рабочих данных в месте, не затронутом воздействием аварии, обеспечит предприятию возможность быстро восстановить свою деятельность, тогда как в обратной ситуации деятельность предприятия может оказаться полностью свернутой из-за аварии.

Сущность репликации данных

Является ли целью репликации данных их публикация в другие офисы, извлечение для анализа или восстановление после аварий, сущность репликации не изменяется. Репликация позволяет обеспечить доступность рабочих данных в режиме онлайн в одном или нескольких офисах, удаленных от основного центра данных, а также поддерживать их копии идентичными исходным базам данных, которые используются для управления бизнесом (синхронизация баз данных).

Технологии репликации данных компании VERITAS

Репликация позволяет синхронизировать одну или несколько вторичных копий данных предприятия с основной или исходной копией, обрабатываемой приложениями. Компания VERITAS предлагает технологии репликации, которые позволяют обеспечить идентичность копий и исходных данных (синхронизацию данных) при следующих способах копирования:

- Из исходной файловой системы в одну или несколько целевых файловых систем на разных компьютерах.

- Из исходной группы томов на одну или несколько целевых групп томов на разных компьютерах.

Репликаторы файловых систем и групп томов поддерживают целостность процесса репликации даже в случае выхода из строя сети или системы. При этом обеспечивается надлежащая производительность.

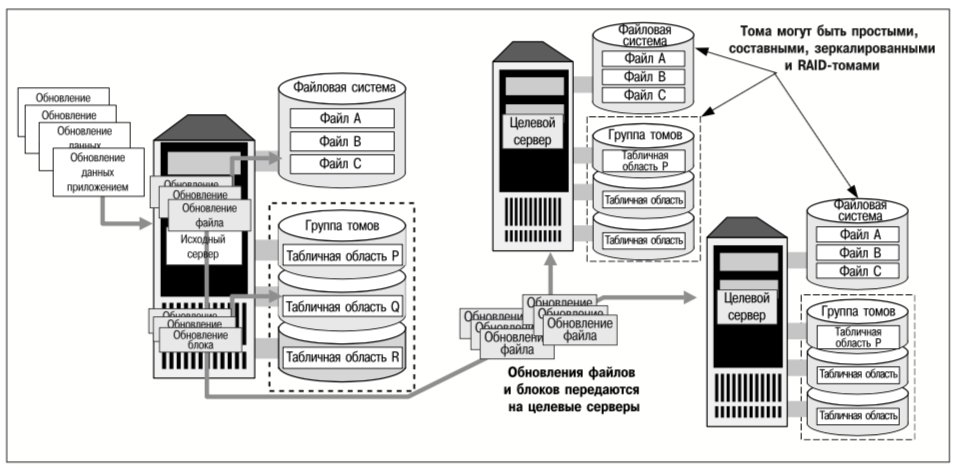

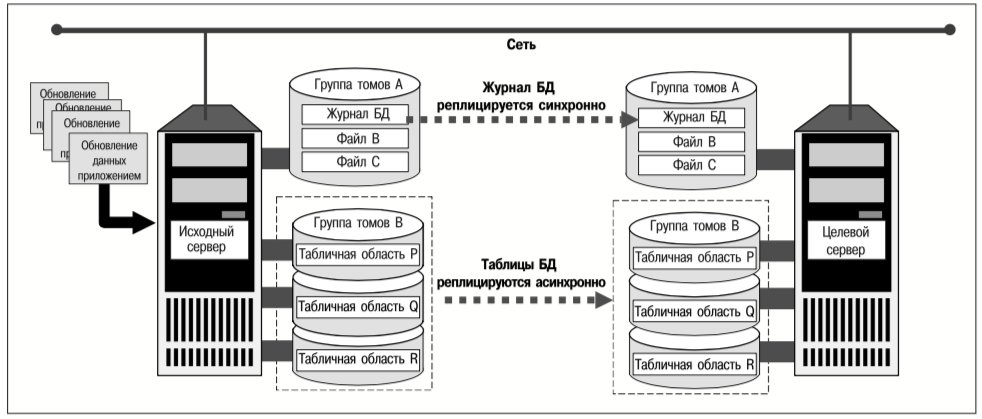

Как показано на рис. 1, приложения выполняются на исходном сервере и обновляют как файлы в файловой системе, так и таблицы БД, хранимые на группе томов (в файлах-контейнерах или на «сырых» устройствах). И реплики файловой системы, и реплики группы томов поддерживаются на двух целевых серверах. На рис. 1 проиллюстрированы три ключевых момента процесса репликации:

- Можно реплицировать либо файловые системы, либо группы томов (содержащие одну или несколько файловых систем). Репликация файловых систем целесообразна в случае большого количества файлов, которые являются неотъемлемой частью сложных бизнес-приложений. Репликация групп томов, как правило, больше подходит для баз данных, хранимых в небольшом количестве крупных файлов, которые, возможно, находятся в нескольких файловых системах на одном или нескольких томах.

- Репликация – это операция типа «один ко многим». Для каждой реплицируемой файловой системы или группы томов существует единственный источник (исходный сервер) и одно или несколько мест назначения (целевые серверы). Исходный сервер обеспечивает доступ приложений к данным для чтения/записи. Реплики файловых систем можно монтировать (подключать) для их использования приложениями и во время выполнения репликации. Реплики групп томов не могут использоваться приложениями, если процесс репликации еще не завершен.

- Для репликации применяются стандартные аппаратные компоненты и сетевые соединения. Чтобы реплицировать данные, не требуется никакого специального оборудования, и нет необходимости в выделении отдельных каналов связи для этой операции (хотя компания VERITAS рекомендует выделять такие каналы в тех случаях, когда пропускная способность и скорость реакции приложений имеют решающее значение). Исходные и вторичные реплики данных необязательно должны храниться на идентичных дисках или томах, но реплицируемые тома должны иметь одинаковую полезную емкость.

В «стеке» доступа к данным и управления ими (см. JetInfo No2) средства репликации находятся либо на уровне файловой системы, либо на уровне диспетчера томов. Реплицируемыми объектами являются либо файловые системы, либо тома, поэтому все базовые средства компании VERITAS, в том числе средства повышения доступности (например, зеркалирование) и производительности (например, Quick I/O for Databases), можно использовать в сочетании с репликацией данных как на исходном сервере, так и на целевых серверах.

Предлагаемые VERITAS программные продукты позволяют проводить репликацию на основе заданных правил (политики). Чтобы удовлетворить требованиям конкретных предприятий, системные администраторы могут определить политику репликации, включая следующие ее параметры:

- Какие файловые системы или группы томов исходного сервера необходимо реплицировать.

- Какие файловые системы или тома целевых серверов являются объектами назначения для репликации.

- Какой должна быть частота синхронизации вторичных копий с исходной.

- Какой должна быть реакция на временные отказы сети и сбои целевых серверов.

После того как политика задана, репликация выполняется автоматически, не требуя вмешательства системного администратора до тех пор, пока не произойдет какое-либо чрезвычайное событие, например, авария такого масштаба, что для восстановления системы потребуется использование реплики данных.

Хотя операции репликации файловых систем и групп томов преследуют одну и ту же основную цель – обеспечение идентичности данных на нескольких компьютерах – между ними существуют определенные различия, которые обусловлены, прежде всего, характером реплицируемых объектов. Учитывая эти различия, можно выбрать оптимальный тип репликации в каждом конкретном случае. В последующих разделах репликация файловых систем и групп томов описывается более подробно.

Репликация файловых систем

Средства репликации файловых систем, реализованные в продукте VERITAS File Replicator (VFR), позволяют реплицировать обновления файлов независимо от физического и логического местонахождения данных. Содержимое файла в реплицируемой файловой системе идентично на исходном и целевом серверах, но не гарантировано, что файлы исходного и целевого серверов хранятся в одних и тех же местах тома или диска.

Репликация файловых систем выполняется синхронно. Это значит, что операции записи данных приложением на исходный сервер считаются незавершенными до тех пор, пока эти данные не будут также записаны на все целевые серверы. Механизм синхронной репликации рассматривается в следующем разделе. Следует отметить, что запись данных приложением в реплицируемые файловые системы по сети может потребовать значительно большего времени, чем их запись в локальные файловые системы. Поэтому репликация файловых систем не подходит для приложений с очень высокой частотой обновления данных или критическими требованиями ко времени реакции приложений.

Поскольку в результате репликации файловых систем данные на целевых серверах всегда являются актуальными, их исходные и вторичные копии никогда не отличаются друг от друга более чем на текущую операцию ввода-вывода. Поэтому нет необходимости вести журнал обновлений, который может быть использован для восстановления данных после сбоя канала связи или целевого сервера. Это позволяет свести к минимуму дополнительные операции ввода-вывода, но порождает и такой недостаток как потеря связи между исходным и целевым серверами, что потребует полной ресинхронизации этих серверов после восстановления связи.

После восстановления вышедшей из строя сети, исходный и целевой серверы должны определить, идентичны ли на них копии реплицируемых файлов. Для этого независимо вычисляется контрольная сумма для каждого файла. Если контрольные суммы для файла на двух серверах не совпадают, то версия файла на целевом сервере заменяется копией с исходного сервера.

По сравнению с восстановлением по журналу репликации, который предоставляет информацию о том, какие данные обновлялись в момент отказа, восстановление путем сравнения контрольных сумм может потребовать много времени. Из-за того, что принят этот метод, средство репликации файловых систем приобретает такой недостаток, как длительное время восстановления после аварии, однако, он компенсируется тем, что непроизводительные затраты во время нормальной работы сведены к минимуму. Поэтому репликацию файловых систем оптимально использовать в наиболее надежных сетях, где отказы, требующие ресинхронизации после восстановления связи, происходят редко.

Репликация файловых систем обладает еще одним достоинством: поскольку о реплицируемых информационных объектах имеются достаточно полные сведения (например, известно, используется ли данный файл), репликация файловых систем может быть двунаправленной.

Приложения на целевом сервере могут обращаться к файлам в реплицированной файловой системе. При определенных условиях файлы, измененные приложениями на целевом сервере, могут быть реплицированы на исходный сервер. Этого нельзя сделать в случае репликации групп томов, которая является строго однонаправленным процессом и не позволяет использовать данные целевого сервера во время репликации.

Репликация групп томов

При репликации групп томов, реализуемой продуктом VERITAS Volume Replicator (VVR), все блоки, записанные на группе томов исходного сервера, реплицируются на тома одного или нескольких целевых серверов независимо от содержания реплицируемых данных. При репликации томов не различаются обновления данных приложениями, обновления метаданных файлов и обновления карты свободного дискового пространства.

Поскольку нет контекстной связи файловых систем и приложений с репликацией группы томов, возможна асинхронная репликация данных между исходным и целевым серверами. Механизм асинхронной репликации рассматривается в следующих разделах. По отношению к приложениям основными преимуществами этого механизма являются обеспечение более высокой производительности приложений и быстрое восстановление после отказов сети.

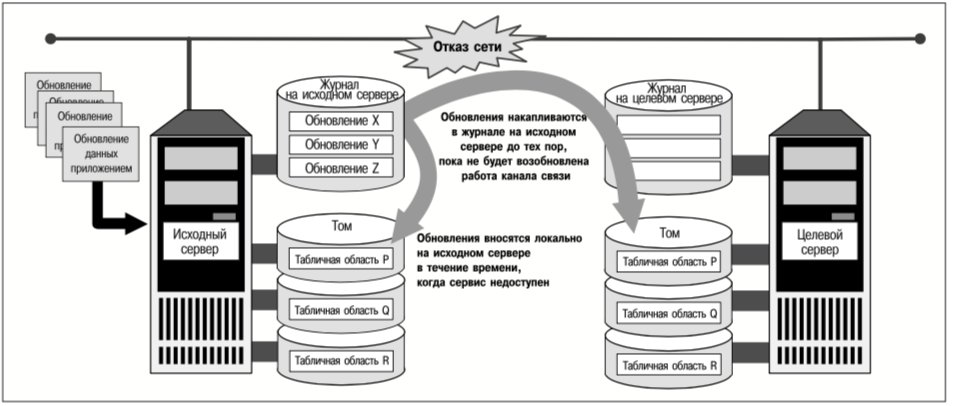

VERITAS Volume Replicator, запущенный на исходном сервере, регистрирует каждое изменение, вносимое в реплицируемую группу томов, прежде чем переслать его на целевые серверы. При отказе сети исходный сервер продолжает регистрировать обновления реплицируемых групп томов локально. После восстановления сети те обновления, которые были зарегистрированы во время ее простоя, пересылаются на целевые серверы. Поэтому репликация групп томов – это оптимальный вариант для тех случаев, когда сеть, соединяющая исходный и целевой серверы, не является абсолютно надежной.

Характер репликации групп томов не позволяет приложениям на целевом сервере использовать реплицируемые данные во время процесса репликации. Таким образом, этот способ репликации наиболее подходит для применения в следующих случаях:

- Публикация данных. Некоторые организации хранят данные на центральном (исходном) сервере и публикуют их для использования на нескольких целевых серверах. Web-страницы, прайс-листы, спецификации продукции и другие документы, используемые в различных офисах предприятия, – вот характерные примеры данных, для которых используется репликация этого типа.

- Восстановление после аварий. Если авария в основном центре данных (где находятся исходные серверы) полностью выводит его из строя, работа может продолжаться в резервном центре данных, т.е. в месте расположения целевых серверов, которое находится достаточно далеко от основного центра данных. (Например, в сейсмоопасном районе такой резервный центр данных должен находиться дальше от основного, чем в случае сейсмически безопасного района). Группы томов исходного сервера можно реплицировать в резервный центр данных. Если на исходном сервере произойдет авария, то приложения можно быстро перезапустить в резервном центре данных, а для возобновления обработки будут использованы актуальные реплики данных.

В этих вышеописанных случаях реплики данных целевого сервера используются после завершения процесса репликации, а не во время его выполнения.

Синхронная репликация

Говорят, что реплицированная группа томов целевого сервера является актуальной, если ее содержимое идентично содержимому томов исходного сервера. Для того, чтобы целевая группа томов была постоянно актуальной, все обновления данных приложениями необходимо синхронно реплицировать на все целевые серверы. Каждое такое обновление необходимо записать как на исходные тома, так и на соответствующие целевые тома, и только после этого приложение сможет продолжить работу. (Это – единственный режим работы VERITAS File Replicator).

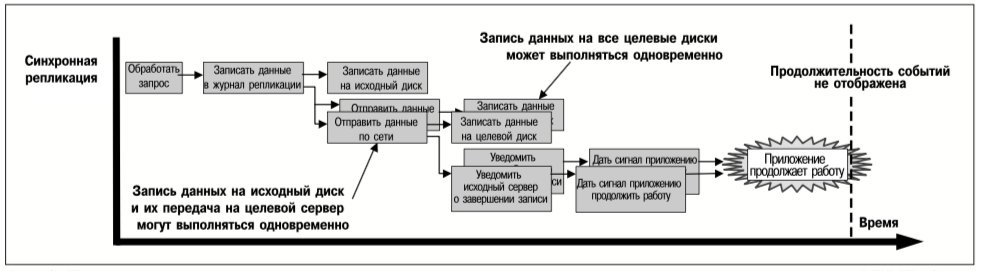

Абсолютно синхронная репликация может привести к тому, что время реагирования приложения окажется неприемлемо большим. VERITAS Volume Replicator использует оптимизацию для уменьшения времени реакции приложений, не создавая при этом возможности для нарушения целостности синхронно реплицированных данных. Операция записи данных приложением на том, синхронно реплицируемый с помощью VERITAS Volume Replicator, считается завершенной после того, как эта операция

- зарегистрирована (т.е. занесена в журнал) на исходном сервере;

- передана на все целевые серверы, а исходный сервер получил подтверждения ее приема от всех целевых серверов.

На рис. 2 показана последовательность действий по данному алгоритму репликации, причем указаны операции, которые могут выполняться одновременно. По сравнению с записью данных на локальный не реплицированный том, запись на синхронно реплицированный том требует большего времени, а задержка определяется следующими факторами:

- временем на регистрацию в локальном журнале (прежде всего – временем на выполнение операций ввода-вывода на диск);

- временем на передачу и подтверждение сообщения, которое необходимо наиболее удаленному (по времени прохождения сообщений) целевому серверу.

Как следует из рис. 2, оптимизация заключается в том, что приложениям не требуется ожидать выполнения операций ввода-вывода на диске целевого сервера. Применение алгоритма репликации, представленного на рис. 2, позволяет защитить данные от потери в случае:

- аварии на исходном сервере, в результате которой его восстановление невозможно, тогда можно использовать реплики данных, существующие на каждом целевом сервере, а также

- отказа целевого сервера или канала связи, тогда, поскольку все изменения регистрируются в журнале на исходном сервере, их можно внести после восстановления работоспособности целевого сервера или канала связи.

Однако, и при такой оптимизации повышение частоты обновлений данных приложения, кратковременная перегрузка сети или просто наличие большого количества целевых серверов может сделать синхронную репликацию неприемлемой при необходимости обеспечить определенную производительность приложений. В таких случаях используется асинхронная репликация данных. Программный продукт VERITAS Volume Replicator поддерживает этот механизм репликации.

Асинхронная репликация

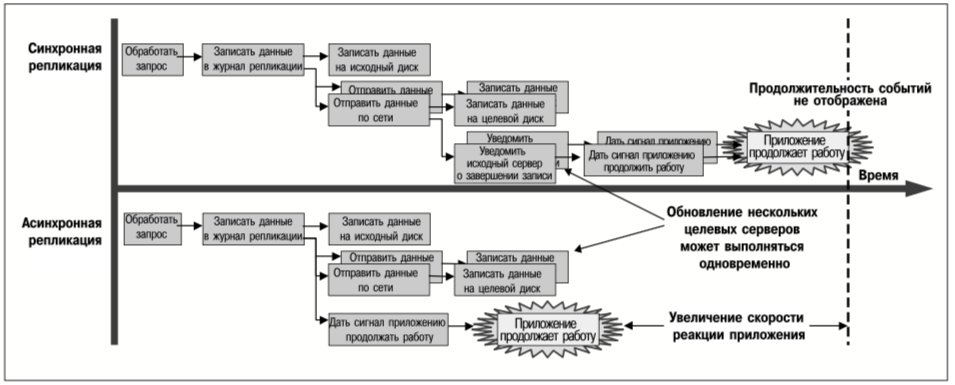

При асинхронной репликации выполнение приложений продолжится, как только их запросы на запись данных будут зарегистрированы в журнале на исходном сервере. Передача и запись данных на тома целевых серверов происходят асинхронно, обычно после того, как приложение уведомлено о завершении операции записи его данных. На рис. 3 показано различие в скорости реакции приложения при синхронной и асинхронной репликации.

Как следует из рис. 3, асинхронная репликация позволяет уменьшить задержку или суммарное время выполнения запроса приложения на запись данных. Однако, более важное следствие асинхронной репликации состоит в том, что кратковременные перегрузки сети не приостанавливают выполнение приложений и не приводят к отказам в обработке запросов на запись данных. Работа приложений, записывающих данные на асинхронно реплицируемые тома, не замедляется и не приостанавливается вследствие перегрузки сети, потому что они выполняются независимо от работы канала связи и целевого сервера.

VERITAS Volume Replicator пересылает на целевые серверы обновления данных томов, сохраненные в журнале регистрации на исходном сервере, по мере того, как это позволяет загрузка сети и целевых серверов. Если перегрузка сети возникает нечасто и ненадолго, то после нормализации нагрузки данные на целевых серверах будут обновлены, т.е. в этом случае реплики на целевых серверах поддерживаются в актуальном состоянии. Если же сеть перегружена постоянно, то объем информации о еще не реплицированных записях (что регистрируется в журнале на исходном сервере) возрастает, и выполнение приложений, в конечном счете, приостановится. Асинхронная репликация позволяет легко преодолеть кратковременную перегрузку сети, но не является средством для увеличения пропускной способности сети в случаях, когда в установившемся режиме пропускная способность сети недостаточна.

Асинхронная репликация имеет следующие преимущества:

- Более быстрая реакция приложений (по сравнению с синхронной репликацией).

- Допустимость кратковременных перегрузок сети.

- Быстрое восстановление данных после выхода из строя целевого сервера или отказа сети.

Недостаток асинхронной репликации заключается в том, что возможны короткие промежутки времени, в течение которых данные на целевых томах не обновляются, следовательно, реплики до некоторой степени утрачивают актуальность. Если в тот момент, когда на тома-реплики еще не записаны последние обновления, выйдет из строя целевой сервер или откажет канал связи, то после восстановления работоспособности этого оборудования из журнала исходного сервера пересылается информация об обновлениях за время простоя, реплики обновляются и их актуальность восстанавливается. Однако, если в это время на исходном сервере случится авария, после которой его работоспособность нельзя будет восстановить, содержимое журнала обновления может оказаться утраченным, и в этом случае на целевом сервере можно восстановить только несколько устаревшие данные.

Чтобы предотвратить значительные потери данных в случае возникновения описанной выше ситуации, системный администратор может установить допустимый предел «неактуальности» реплики (т.е. указать максимальное количество операций записи, на которое реплика на целевом сервере может «отставать» от данных на исходном сервере). В случае превышения этого предела выполнение операций записи данных приложениями на исходном сервере приостанавливается (сигнал о завершении операции не подается) до тех пор, пока количество неотправленных обновлений не станет меньше установленного предельного значения. Таким образом, можно гарантировать, что при любых обстоятельствах реплицированные данные будут отличаться от исходных не более чем на указанное в качестве предела количество операций записи.

Хотя при асинхронной репликации не гарантируется полная непротиворечивость данных, этот метод часто используется потому, что он позволяет обеспечить необходимую производительность. Как кратковременная перегрузка, связанная с обновлением данных, так и сильная загруженность сети, вызванная другими причинами, могут увеличить время реакции приложений до неприемлемых значений. Асинхронная репликация позволяет сократить время реакции приложений, так как в этом случае приложения могут продолжать работу, не ожидая завершения большинства операций, необходимых для удаленной репликации данных, следовательно, время реакции приложений уменьшается на величину, равную времени выполнения таких операций репликации. Именно это свойство может оказаться решающим при выборе практически эффективного способа репликации.

Использование реплицированных томов

При репликации томов диспетчер репликации (replication manager) не имеет информации о содержимом обновляемых блоков: хранятся ли в них данные файлов, метаданные файловой системы, страницы баз данных или другие объекты. Без такой информации диспетчер репликации не может определить состояние файловых систем и баз данных на целевых серверах. Поэтому репликация групп томов является строго однонаправленным процессом: блоки копируются с исходного сервера на один или несколько целевых, но не наоборот. Кроме того, данные с реплицированных томов целевых серверов нельзя использовать, если процесс репликации продолжается.

Комбинированные методы восстановления

Если в системе, где используется асинхронная репликация, происходит такая авария, из-за которой невозможно восстановить работоспособность исходного сервера, данные на томах целевых серверов могут оказаться несколько устаревшими. В момент аварии некоторые обновления, уже полностью обработанные на исходном сервере, возможно, еще передавались по сети или только были зарегистрированы в журнале исходного сервера для последующей передачи. Такие обновления не отражаются в базе данных целевого сервера, которая используется для восстановления после аварии. Как правило, в подобных случаях для восстановления данных необходимо применять комбинированные методы, в которых используются функции более высокого уровня (например, журналы баз данных).

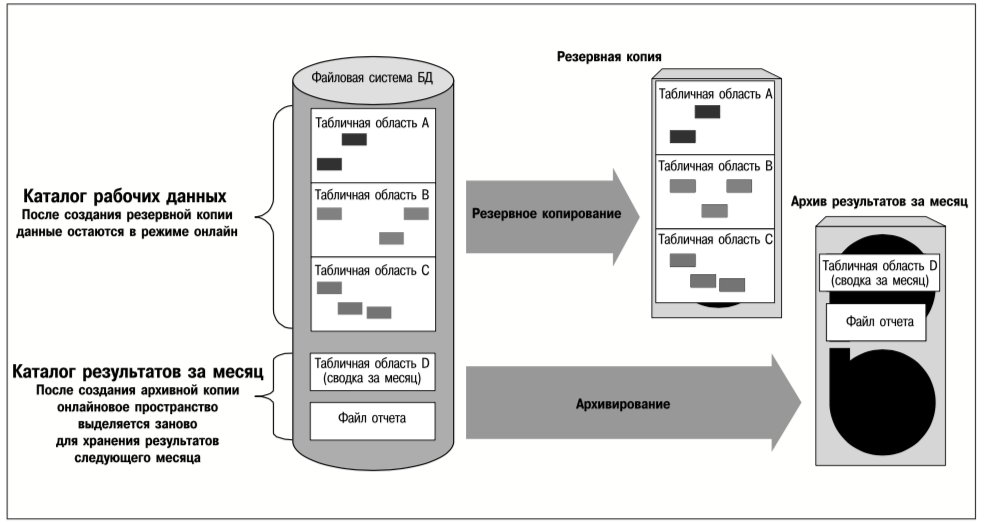

Например, табличные области БД можно хранить в файлах-контейнерах в файловых системах, созданных на томах реплицированной группы. Группу томов можно реплицировать асинхронно, чтобы обеспечить приемлемую производительность. В то же время файл, содержащий журнал базы данных, может принадлежать файловой системе, которая синхронно реплицируется на тома другой группы. Таким образом, хотя авария на исходном сервере может привести к потере обновлений таблиц во время передачи этих обновлений, журнал восстановления, необходимый для создания текущей реплики базы данных на целевом сервере, не будет затронут аварией и останется актуальным на целевом сервере. Поскольку этот журнал реплицируется синхронно, в нем отражаются все изменения базы данных, даже если они еще не были внесены в образ самой базы данных. Поэтому БД целевых серверов можно восстановить путем воспроизведения актуального журнала. На рис. 4 представлена описанная выше схема комбинированной репликации.

Аварии и отказы: сравнительный анализ

Выше уже упоминалось о том, как важна репликация данных для восстановления систем после аварий. С помощью актуальных удаленных реплик критических данных предприятие может быстро восстановить свою работоспособность после аварии. Наличие актуальных данных на удаленном сервере – это одно из самых важных условий бесперебойной работы предприятия, но не единственное такое условие. Если принять во внимание ряд других факторов, например, кадровые, коммуникационные и транспортные аспекты, то оказывается, что перенос деятельности из основного центра данных в резервный целесообразен только в случае действительно серьезной аварии. Как правило, оптимальным является устранение системных сбоев и отказов устройств хранения данных локально, без вовлечения в разрешение этих проблем удаленных резервных центров данных.

- Зеркалирование или RAID-технологии с автоматическим использованием запасного диска (automatic sparing) являются оптимальными решениями для преодоления отказов устройств хранения данных.

- Кластеризация с автоматическим переключением выполнения приложений на другие серверы (эта технология рассматривается в следующей главе) – это решение позволяет устранить последствия системных сбоев, в результате которых повреждения центра данных незначительны и он сохраняет функциональность.

Важной составной частью всякой стратегии восстановления данных предприятия после аварий должны быть объективные критерии, позволяющие различать следующие события:

- Отказы локальных устройств и систем, которые можно устранить локально.

- Кратковременные отказы каналов связи или целевых серверов, которые могут временно прервать репликацию данных.

- Серьезные аварии, после которых необходимо перенести производственную деятельность в резервный центр данных, а также надлежащим образом реагировать на каждое из них.

Отказы сети, а также сбои в работе как исходного, так и целевого сервера могут прервать процесс репликации томов. Журналы репликации являются тем механизмом, который после устранения неисправностей позволяет восстановить данные, ресинхронизировать их и возобновить репликацию, когда все необходимые для этого средства снова станут доступными. Обновления хранятся в журнале репликации на исходном сервере до тех пор, пока не станет возможным переслать их на целевые серверы. Журналы репликации на целевых серверах используются в том случае, если из-за аварии на исходном сервере необходимо перенести выполнение приложений на один из целевых серверов, т.е. создать новый исходный сервер.

Обмен контрольными сообщениями при репликации

VERITAS Volume Replicator поддерживает механизм обмена периодическими контрольными сообщениями (heartbeats) между исходным сервером и каждым из целевых серверов. Такой обмен сообщениями гарантирует, что обе стороны, участвующие в репликации данных, будут знать о состоянии соединения в любой момент времени независимо от того, существует ли в данный момент трафик операций ввода-вывода приложения или нет. Это позволяет обнаруживать отказы канала связи с упреждением, а не в тот момент, когда приложения попытаются записать данные на реплицированные тома.

Репликация и восстанавливаемость данных

VERITAS Volume Replicator учитывает порядок записи блоков между исходным и целевыми серверами. Это гарантирует, что поверх актуальных обновлений не будут записаны более старые обновления тех же блоков, поступившие позже из-за обстоятельств, связанных с загрузкой сети. Сохранение порядка записи также необходимо при восстановлении данных после аварий, например, чтобы предотвратить замену актуальных данных, записанных до аварии, более старыми копиями в процессе восстановления.

Репликация и непротиворечивость БД

Если в базе данных не имеется

- незавершенных транзакций и

- не записанных на диск данных в ее кэше,

то говорят, что ее образ на диске является непротиворечивым с точки зрения транзакций, и представляет собой объект, годный для резервного копирования или восстановления данных после аварии. Другие приложения и диспетчеры данных (data managers) также имеют свои собственные уникальные критерии непротиворечивости данных, которые VERITAS Volume Replicator выявить не в состоянии. Поскольку требования к непротиворечивости данных зависят от приложения, то в состав VERITAS Volume Replicator включены программные интерфейсы (API) для внутреннего контроля (in-band control), которые позволяют зарегистрированным на исходном сервере приложениям в определенные моменты передавать в потоке реплицируемых данных сообщения на целевые серверы. Приложение на исходном сервере может использовать эти API для передачи контрольного сообщения на целевые серверы, когда произойдет какое-либо важное для приложения событие (например, окончание рабочего дня). На рис. 6 приведена схема применения внутреннего контроля в процессе репликации.

Контрольные сообщения фактически «замораживают» репликацию на целевых серверах. Данные на целевых серверах «замораживаются» в том состоянии, которое они имели на исходном сервере в момент ввода контрольного сообщения в поток реплицируемых данных. Зарегистрированное приложение на каждом целевом сервере принимает контрольное сообщение, обрабатывает его и вызывает соответствующий API, чтобы возобновить репликацию, как представлено на схеме, приведенной на рис. 6.

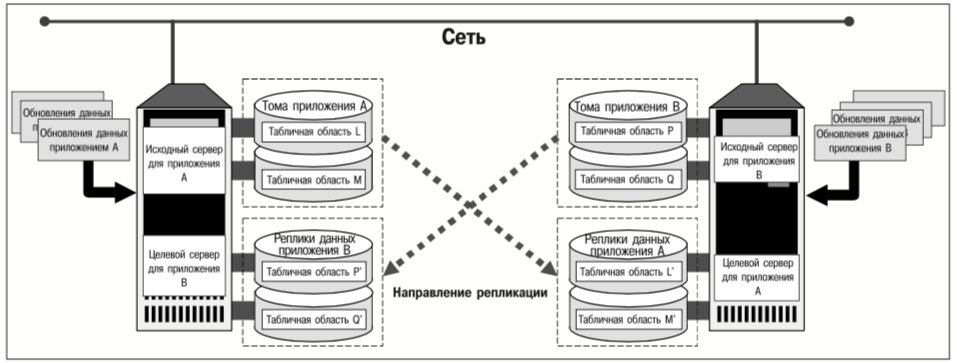

Взаимное восстановление данных после аварий

Роль конкретного сервера в процессе репликации (является он исходным или целевым) определяется для каждой реплицируемой группы томов или файловой системы. Например, вполне возможна ситуация, когда сервер является исходным для одной реплицируемой группы томов и целевым для другой. На рис. 7 показано, как такую ситуацию можно использовать для взаимного восстановления данных после аварий.

Система, изображенная на рис. 7, включает в себя серверы, выделенные для приложений A и B. Данные приложения A реплицируются на группу томов, которая находится на сервере приложения B, и наоборот. Если один из этих двух серверов выйдет из строя, то его приложение можно будет запустить на работоспособном сервере с актуальными данными.

Если предприятие расширяется и устанавливает выделенные сервера приложений, целесообразно рассматривать взаимное восстановление данных на основе технологии репликации как часть стратегии расширения. При минимальных капиталовложениях в:

- устройства данных, хранения для реплицированных

- увеличение производительности серверов и объёмов памяти для выполнения репликации данных и обеспечения надлежащей производительности приложений в случае переключения их выполнения на другие серверы, а также

- сеть с пропускной способностью, достаточной для передачи потока реплицируемых данных в дополнение к обычному рабочему трафику, предприятие обеспечит себе быстрое возобновление функционирования в полном объеме в случае, если авария выведет из строя весь центр данных.

Кластеризация

Обеспечение доступности бизнес-приложений

Обработка данных предприятия

Ранее рассматривалось управление онлайновыми данными предприятия и устройствами их хранения и было показано, что базовые технологии компании VERITAS (VERITAS Foundation) обеспечивают высокую доступность данных, производительность доступа к которым может масштабироваться в соответствии с растущими потребностями бизнеса. Однако, для успешной деятельности предприятия недостаточно только иметь данные в режиме онлайн. Необходимо также иметь высоко доступную систему обработки этих данных. Предприятие должно решить следующие проблемы:

- Как обеспечить непрерывное функционирование прикладного сервиса даже в случае отказа систем или выхода из строя центра обработки данных?

- Как повысить производительность приложений по мере расширения предприятия и увеличения нагрузки на его вычислительные ресурсы?

- Как осуществить централизованное управление большим количеством систем при разумных затратах?

Продукт VERITAS Cluster Server обеспечивает решение этих проблем. Кластеризация позволяет координировать выполнение приложений на нескольких серверах как для повышения их доступности, так и для обеспечения их масштабируемости.

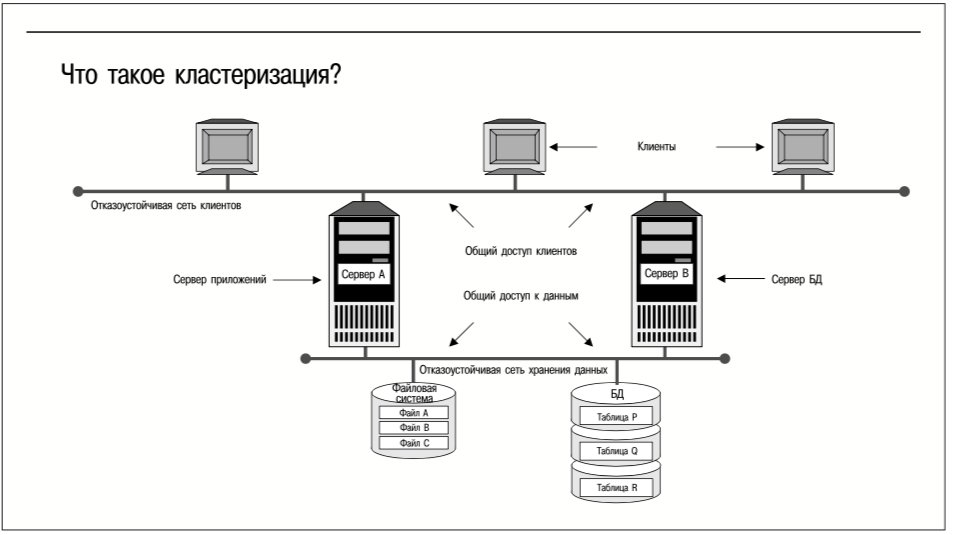

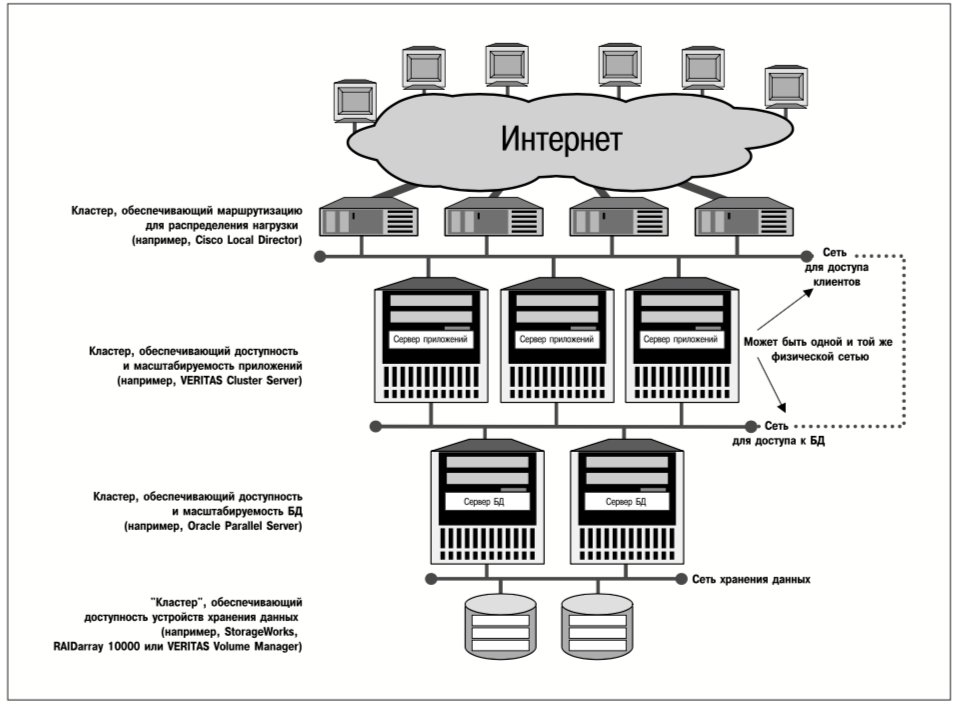

Что такое кластеризация?

В широком смысле слова кластер – это любой набор соединенных между собой компьютеров, работа которых координируется для получения какого-либо полезного эффекта. На рис. 8 представлены основные свойства кластеров. Кластеризация чаще всего используется для повышения доступности приложений и обеспечения их масштабируемости. Некоторые технологии кластеризации также обеспечивают единый образ системы, что позволяет централизованно управлять большим количеством компьютеров как единой системой из единой точки управления.

Зачем использовать кластеры?

Привлекательность кластеризации для пользователей компьютеров обусловлена тем, что кластеры потенциально способны решить некоторые давние проблемы, связанные с обработкой информации:

- В случае выхода сервера из строя или отказа приложения другой сервер из того же кластера может взять на себя эту рабочую нагрузку, поскольку все серверы в кластере соединены с одними и теми же устройствами хранения данных и клиентами.

- Если выйдет из строя сетевое соединение, клиенты могут использовать альтернативные маршруты для получения доступа к данным и продолжения своей работы.

- Если потребности приложения в ресурсах становятся слишком большими для существующих серверов, можно подключить дополнительные серверы и перераспределить рабочую нагрузку между большим количеством серверов.

- Несмотря на увеличение количества кластеризованных серверов в центре обработки данных, управление системой во многом остается централизованным, что позволяет не увеличивать штат системных администраторов, а значит, не увеличивать затраты.

- Если центр обработки данных полностью выйдет из строя, удаленные компьютеры, включенные в кластер этого центра, могут взять на себя его рабочую нагрузку и возобновить обработку информации, используя реплику онлайновых данных.

Все перечисленные преимущества можно реализовать в той или иной степени с помощью технологии кластеризации. Программный продукт VERITAS Cluster Server (VCS) поддерживает до 32 соединенных между собой серверов, работающих под управлением ОС Solaris, HP-UX или Windows NT как связанная система, взаимно защищая запущенные на них приложения от отказов. В сочетании с программными продуктами VERITAS SANPoint Volume Manager и File System программный продукт VERITAS Cluster Server образует пакет SANPoint Foundation HA. Эта технология кластеризации компании VERITAS позволяет нескольким копиям приложения выполняться параллельно на разных серверах, в результате чего суммарная производительность превышает производительность любого отдельного сервера.

Приложения и кластеры

Поскольку кластеризация существенно повышает эффективность работы приложений, рассмотрение этой технологии целесообразно начать с объяснения того, что VCS рассматривает приложение как сервис, предоставляемый группой взаимосвязанных системных ресурсов. Например, прикладной сервис обслуживания Web-страниц может состоять из следующих компонентов:

- дисков, на которых хранятся обслуживаемые Web-страницы;

- тома, созданного на основе этих дисков;

- файловой системы, использующей этот том;

- базы данных, табличные области которой являются файлами в этой файловой системе, а записи содержат указатели на страницы;

- платы сетевого интерфейса, используемой для экспорта Web-сервиса;

- одного или нескольких IP-адресов, связанных с данной платой (платами) сетевого интерфейса;

- прикладной программы и связанных с ней библиотек.

Для VCS существуют два важных аспекта такого представления прикладного сервиса в виде совокупности ресурсов:

- Чтобы какой-либо сервис выполнялся на определенном сервере, последнему должны быть до-ступны все ресурсы, необходимые для данного сервиса.

- Составляющие сервис ресурсы являются взаимозависимыми; это означает, что для начала работы одних ресурсов (например, файловой системы) необходимо, чтобы уже функционировали другие ресурсы (например, тома).

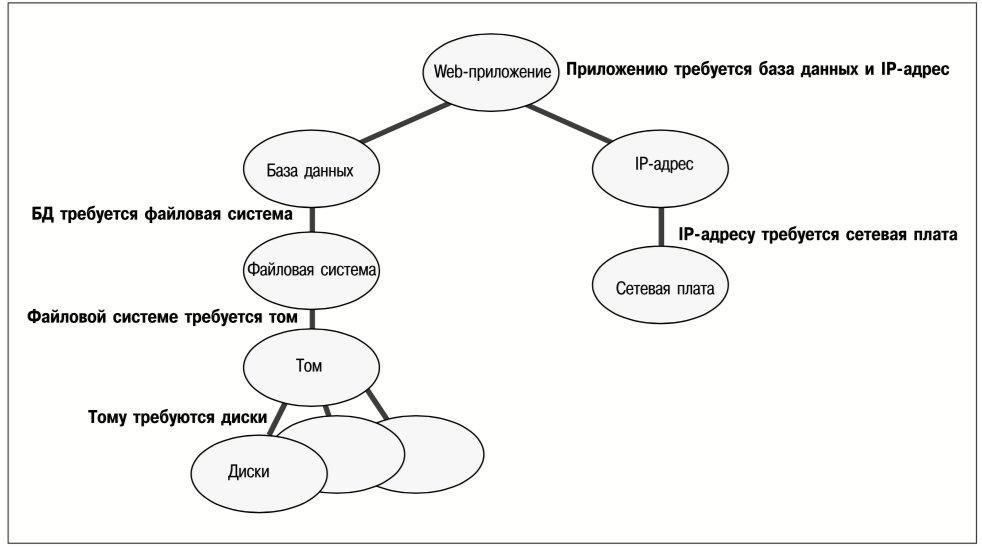

VERITAS Cluster Server представляет ресурсы, входящие в состав сервиса, в виде графа, на котором узлы изображают ресурсы, а соединяющие их линии – зависимости. На рис. 9 приведен граф зависимостей между ресурсами для вышеописанного прикладного Web-сервиса.

На рис. 9 нижние (дочерние) узлы представляют ресурсы, необходимые для функционирования ресурсов, изображенных в верхнем (родительском) узле. Так, например, для функционирования тома необходимо, чтобы были доступны ресурсы дисков; для файловой системы необходимо, чтобы том был активен и т. д.

Важно отметить, что граф зависимости ресурсов, изображенный на рис. 9, состоит из двух независимых поддеревьев ресурсов: вершиной одного является база данных, а другого – IP-адрес для связи с клиентами. Web-приложению требуется как база данных, так и связь с клиентами; а в остальном эти два поддерева являются независимыми друг от друга.

Запуск и останов ресурсов

VCS поддерживает как язык описания, так и графический интерфейс для задания графов зависимостей между ресурсами. Демон (резидентная программа) VCS для контроля и мониторинга кластера называется HAD (High Availability Daemon), он использует результирующие графы при запуске и останове прикладных сервисов. Дочерние ресурсы должны быть активными, только при этом условии можно будет запустить их родительские ресурсы. Демон HAD запускает сервис, активизируя (переводя в режим онлайн) ресурсы, представленные концевыми узлами на графе зависимостей ресурсов этого сервиса. Как видно из рис. 9, диски и сетевую плату можно активизировать одновременно, потому что они не зависят друг от друга. Как только диски будут переведены в режим онлайн, можно активизировать том; как только сетевая плата будет переведена в режим онлайн, можно активизировать IP-адрес; и т. д. Родительский ресурс можно активизировать только после того, как все необходимые ему дочерние ресурсы будут переведены в режим онлайн. Так, Web-приложение, представленное на рис. 9, не может быть запущено до тех пор, пока не будут активизированы база данных и IP-адрес.

Аналогично, при останове сервиса демон HAD начинает с вершины графа. В примере, приведенном на рис. 9, он сначала деактивирует Webприложение, затем базу данных и IP-адрес (параллельно) и т. д.

Группы ресурсов VCS, которые рассматривались до сих пор, известны как failover группы. В каждый момент времени ресурсы из такой группы могут находиться в режиме онлайн только на одном кластерном сервере. На двух серверах нельзя одновременно запустить прикладной сервис, предоставляемый такой группой ресурсов, и обрабатывать одни и те же данные.

Демон HAD также распознает взаимозависимости между сервисами. Например, может потребоваться запрет на одновременную работу двух каких-либо сервисов, как в случае тестовой и рабочей версий одного и того же приложения. Такие связи можно выразить с помощью графов зависимостей между группами ресурсов, на которых указываются зависимости между сервисами. Демон HAD учитывает эти зависимости. Например, HAD можно сконфигурировать так, чтобы не допустить одновременной работы тестовой и рабочей версий приложения.

Чтобы обеспечить масштабирование приложений, демон HAD поддерживает также группы параллельных ресурсов. Ресурсы, составляющие такую группу, могут находиться в режиме онлайн на нескольких серверах одновременно. Это позволяет приложениям, требования которых превышают возможности одного сервера, работать в виде нескольких копий, каждая на отдельном сервере. В случае группы параллельных ресурсов приложение отвечает за координацию одновременных обращений нескольких его копий, работающих на нескольких серверах кластера, к совместно используемым данным. Программные продукты SANPoint Volume Manager и File System поддерживают масштабируемость приложений, разрешая томам и файловым системам находиться в режиме онлайн по отношению к нескольким серверам одновременно.

Управление ресурсами кластера

Для управления различными типами ресурсов необходимо выполнение различных действий. Например, для активизации SCSI-диска требуется выполнение команды spin-up, тогда как для активизации базы данных Oracle – запуск процесса СУБД Oracle, а значит выполнение соответствующей команды (или команд) startup. С точки зрения демона HAD достигается один и тот же результат – ресурс становится доступным для использования. Однако, выполняемые при этом действия совершенно разные. VERITAS Cluster Server успешно обрабатывает управляющие команды, несмотря на их разнообразие, поскольку в этой программе реализован надежный способ обработки, который также предоставляет разработчикам приложений и аппаратного обеспечения возможность интегрировать новые типы ресурсов в этот продукт.

Каждый тип ресурсов, поддерживаемый в кластере VCS, связан с каким-либо агентом. Агентом называется инсталлированная программа, которая зарегистрирована демоном HAD. Агент VCS имеет три метода или три точки входа, в которых его можно вызвать:

- Метод онлайн, вызываемый HAD, когда требуется активизировать ресурс.

- Метод оффлайн, вызываемый HAD, когда требуется деактивировать ресурс.

- Метод мониторинга, вызываемый HAD, когда требуется проверить рабочее состояние ресурса.

HAD вызывает методы агента ресурса в надлежащей последовательности для запуска и останова прикладных сервисов, для переноса выполнения прикладного сервиса на другой сервер в случае отказа (в сущности, перенос – это останов сервиса на одном сервере и его немедленный запуск на альтернативном сервере) и для мониторинга состояния ресурса. Каждый метод агента характеризуется набором параметров, называемых атрибутами, значения которых задаются в процессе конфигурирования и передаются методу при его вызове демоном HAD.

Поскольку агенты ресурсов кластеров VCS имеют простую структуру, разработка агентов для поддержки дополнительных типов ресурсов является сравнительно простой задачей. Например, в состав продукта VERITAS Database Edition for Oracle входят агенты, которые позволяют включить базы данных Oracle в ресурсы кластера.

Компоненты кластера и его конфигурация

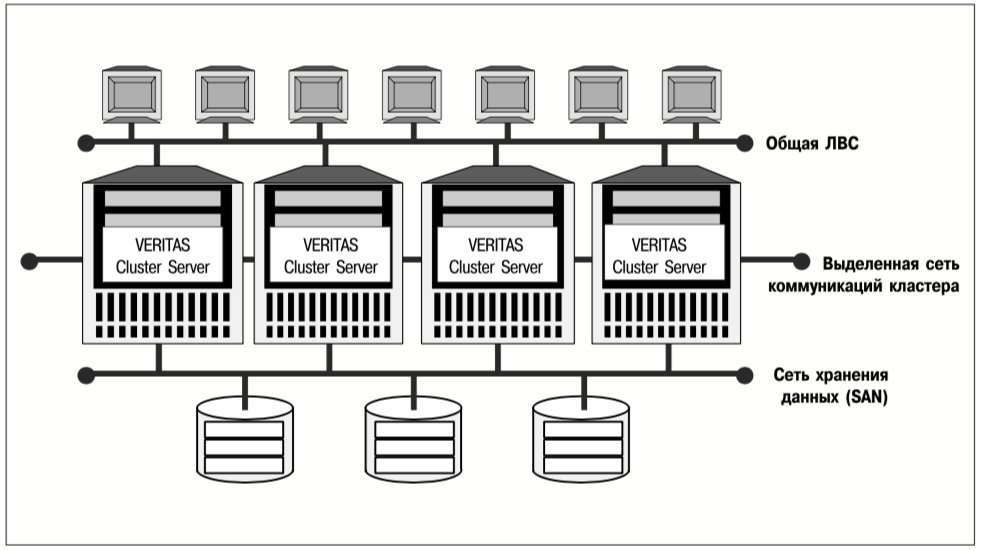

Используя описанную выше архитектуру прикладного сервиса, VERITAS Cluster Server реализует отказоустойчивую среду выполнения приложений, в которой клиентам обеспечивается практически постоянный доступ к приложениям даже в случае выхода из строя целой системы. Аппаратные компоненты, входящие в состав кластера, представлены на рис. 10.

В состав кластера VCS может входить от 2 до 32 соединенных между собой серверов, на которых работает программное обеспечение VERITAS Cluster Server. Все серверы, объединенные в кластер, должны иметь доступ к одним и тем же клиентам, что обеспечивает принципиальную возможность предоставления любого клиентского сервиса, предлагаемого кластером, не одним, а несколькими серверами. В кластере должна быть выделенная сеть (private network), соединяющая серверы – узлы кластера, чтобы сетевой трафик общей ЛВС не оказывал влияние на коммуникацию внутри кластера.

Хотя можно создать такие кластеры, в которых связи между устройствами хранения данных и серверами будут неполными (т.е. не все серверы будут соединены со всеми устройствами хранения), в наиболее практичных и управляемых кластерных конфигурациях используются сети хранения данных (SAN), что обеспечивает полные физические связи между устройствами хранения и серверами.

Компоненты VCS

На каждом сервере, являющемся узлом кластера, работают некоторые или все шесть основных функциональных компонентов VCS:

- Демон HAD или ядро кластера (cluster engine), выполняемый в реальном времени процесс, который отслеживает состояние всех копий VCS в кластере, а также управляет изменениями этого состояния (например, переносом выполнения приложения с отказавшего на альтернативный сервер) в соответствии с политиками изменения состояния кластера и управления кластером.

- Модуль коммуникаций, использующий специализированные отказоустойчивые протоколы с малой задержкой для взаимодействия с другими копиями VCS и непрерывного отслеживания состояния связи внутри кластера.

- Транслятор, который читает графы зависимости ресурсов, выраженные на языке конфигурации VCS, и интерпретирует их для демона HAD.

- Оценщик нагрузки, который оценивает нагрузку на серверы, что позволяет копиям HAD выделить серверы для прикладных сервисов так, чтобы создаваемая приложениями нагрузка оптимально распределилась между ресурсами кластера.

- Агенты для ресурсов каждого типа, представленного в кластере.

- Интерфейс системного администрирования – в виде командной строки и графический.

Соединения внутри кластера

Копии VCS взаимодействуют друг с другом через два или более отдельных физических соединения, хотя бы одно из которых должно быть выделенным (зарезервированным для передачи сообщений VCS). В некоторых конфигурациях для связи между различными копиями VCS можно использовать общий раздел диска

Наличие нескольких выделенных соединений позволяет частично решить общую проблему кластеризации – неспособность сервера отличить отказ взаимодействующего с ним другого сервера от отказа (единственного) канала связи между ними. Когда невозможно отличить отказ сервера от отказа канала связи, кластерный сервер не может инициировать процесс переноса выполнения приложения на альтернативный сервер. Если бы это произошло, оказалась бы возможной ситуация, когда два или больше серверов, которые не могут взаимодействовать между собой, запускают один и тот же прикладной сервис для обработки одних и тех же данных. В случае возникновения этой ситуации искажение данных неизбежно почти при любом дальнейшем развитии событий.

Соединения с клиентами и устройствами хранения данных в кластерах

Для удобства управления необходимо, чтобы серверы, составляющие кластер VCS, были подключены к общей ЛВС и могли обращаться к одним и тем же устройствам хранения данных. Кластеры, в которых устройства хранения данных подключены к общей для узлов кластера SCSI-шине, как правило, включают в себя не более четырех серверов, потому что применяемая в SCSI-шине схема арбитража с фиксированным приоритетом обычно приводит к перегрузке (starvation) шины, если к ней подключено более четырех инициаторов операций ввода-вывода (серверов). Кроме того, SCSI-шина позволяет соединить между собой максимум 16 устройств (компьютеров, дисков, накопителей на магнитной ленте и RAIDмассивов). Подключение дополнительных серверов к кластеру с общей SCSI-шиной уменьшает количество адресуемых устройств хранения данных, то есть у кластера с общей SCSI-шиной имеется свойство, прямо противоположное масштабированию.

Сети хранения данных (SAN), построенные по технологии Fibre Channel (FC), позволяют частично устранить указанный недостаток общей SCSI-шины. Протокол Fibre Channel Arbitrated Loop позволяет подключить до 126 узлов (устройств с портами стандарта Fibre Channel), при этом допустимы любые комбинации компьютеров, подсистем и устройств хранения данных.

Теоретически протокол Switched Fabric позволяет соединить между собой 224 устройств (хотя на практике сети хранения данных, работающие по протоколу Switched Fabric, обычно соединяют между собой не более 200 устройств), что фактически решает такую проблему кластеризации, как подключение большого количества устройств хранения данных.

Устройства хранения данных для кластеров

В принципе для хранения данных кластера можно использовать любой тип устройств хранения, допускающих подключение к нескольким узлам, в том числе диски, подключаемые напрямую. Однако, целью кластеризации является обеспечение надежной и масштабируемой обработки данных. Поэтому для обеспечения максимальной доступности всей системы оптимальным является применение отказоустойчивых или высоко доступных подсистем хранения данных с несколькими путями доступа к узлам кластера. На практике большинство кластеров конфигурируют с использованием отказоустойчивых внешних RAID-массивов того или иного типа. Агенты VERITAS Cluster Server имеются для всех основных типов RAID-массивов.

Применение кластеров

Перенос выполнения приложений в случае отказа

Одним из самых важных применений кластерной технологии является повышение доступности прикладных сервисов. Прикладной сервис может выйти из строя вследствие отказа критически важного ресурса (например, прикладной программы, адаптера, соединяющего сервер с данными, и т. д.) или отказа сервера, на котором работает это приложение. Какова бы ни была причина отказа, демон HAD VCS, обнаружив его (по отсутствию отслеживаемых периодических контрольных сообщений группы ресурсов, составляющих сервис), инициирует процесс переноса выполнения приложения на другой сервер, т.е. запуск приложения на другом сервере.

Каскадный перенос выполнения приложений в случае отказа

По существу, при конфигурировании кластера VCS администратор составляет для каждого из прикладных сервисов упорядоченный список серверов, которым разрешается выполнять данный сервис. Так определяется каскадный перенос выполнения приложений в случае отказов. Если физическая конфигурация позволяет, то каждый из серверов кластера можно назначить в качестве разрешенного для данной группы сервисов. Пусть в кластере, изображенном на рис. 11, некоторый прикладной сервис S разрешено выполнять на серверах A, B и C (в указанном порядке серверов). Если сервер A работоспособен в момент запуска приложения S, оно выполняется на этом сервере. Если сервер A выйдет из строя, то VCS перезапустит группу ресурсов сервиса S на сервере B. Если сервер B выйдет из строя до того, как будет восстановлена работоспособность сервера A, то VCS перезапускает группу ресурсов сервиса S на сервере C. Если ни один из серверов A, B и C не работоспособен, приложение S не выполняется, поскольку сервер D не был указан в качестве разрешенного сервера для прикладного сервиса S.

Подключение устройств хранения данных и перенос выполнения приложений в случае отказа

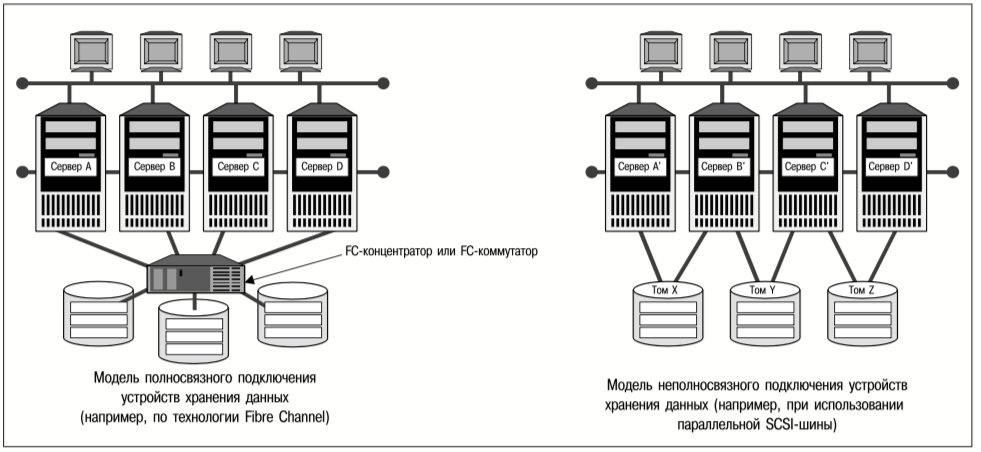

Для того, чтобы прикладной сервис мог выполняться на некотором сервере, последний должен иметь доступ ко всем ресурсам указанного сервиса. Ограниченный доступ к устройствам хранения данных и программному обеспечению приводит к ограничению выбора серверов, на которых могут выполняться те или иные сервисы. Устройства хранения данных могут не иметь прямых соединений со всеми серверами кластера. На рис. 11 приведены примеры неполносвязного и полносвязного (обеспечивается через SAN) подключения устройств хранения в кластере.

- При полносвязном подключении устройств хранения данных каждый сервер в кластере имеет прямые физические соединения со всеми устройствами хранения в этом кластере.

- При неполносвязном подключении устройств хранения данных не все серверы имеют прямые соединения со всеми устройствами хранения.

В аппаратной конфигурации с полносвязным подключением устройств хранения данных любой сервер кластера можно назначить в качестве альтернативного для любой группы прикладных сервисов. Так, в кластере, изображенном слева на рис. 11, выполнение прикладного сервиса, обычно запускаемого на сервере A, можно перенести в случае отказа на серверы B, С и D в указанном или любом другом порядке. В кластере же, изображенном справа на рис. 11, выполнение прикладного сервиса, обычно запускаемого на сервере A’, можно перенести в случае отказа на сервер B’, но не на другие серверы, потому что они не имеют доступа к данным и программному обеспечению этого сервиса.

Аналогично, выполнение прикладного сервиса, обычно запускаемого на сервере B’, можно перенести в случае отказа на сервер A’, при условии, что ресурсы этого сервиса используют только том X или зависят только от этого тома. Если же все ресурсы рассматриваемого сервиса используют только том Y или зависят только от этого тома, то выполнение сервиса в случае отказа можно перенести на сервер C’. Но если ресурсы данного прикладного сервиса используют как том X, так и том Y или зависят от обоих томов, то выполнение этого сервиса нельзя перенести на альтернативный сервер в случае отказа.

Этот пример показывает, насколько внимательным должен быть системный администратор при конфигурировании кластеров в тех случаях, когда имеющиеся аппаратные средства обеспечивают только неполносвязное подключение устройств хранения данных. Аппаратное решение, обеспечивающее полносвязное подключение устройств хранения данных (например, через SAN), гораздо предпочтительнее в связи с его гибкостью, управляемостью и возможностью расширения.

Масштабируемость приложений

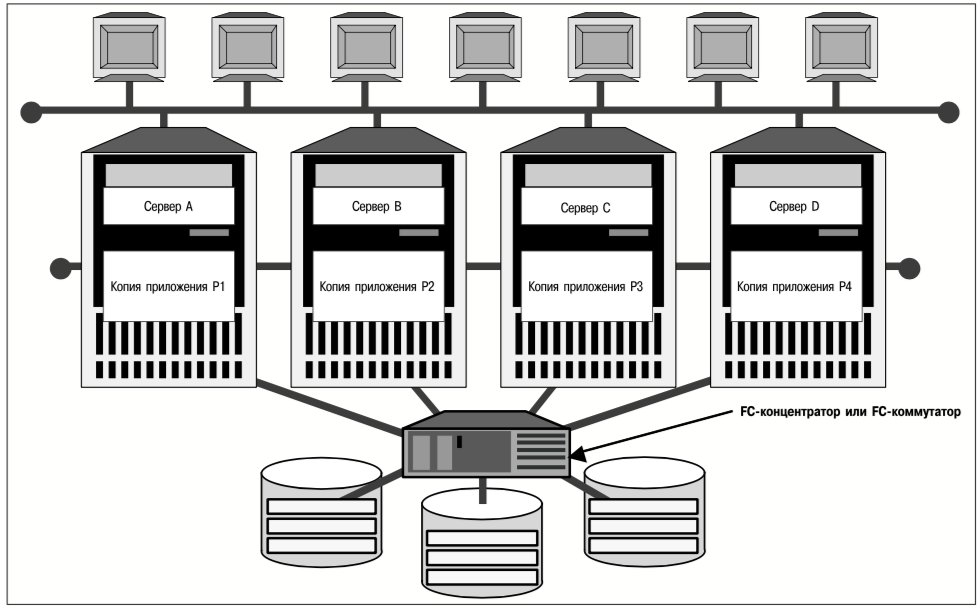

Используя группы параллельных ресурсов сервиса, VCS может поддерживать одновременное выполнение прикладного сервиса на нескольких серверах. На рис. 12 представлен кластер, сконфигурированный для одновременного выполнения параллельного приложения на нескольких серверах.

Изображенный на рис. 12 кластер выполняет на каждом из своих четырех серверов копию прикладного сервиса P. Демон HAD распознает группы параллельных ресурсов сервиса и автоматически запускает все четыре копии приложения при инициализации кластера. Во многих реализациях технологии параллельных групп сервисов каждая копия приложения обрабатывает свою собственную копию данных, то есть не происходит совместное использование файловой системы или тома. Такой сценарий особенно популярен для масштабируемых Web-сервисов. Если же необходимо обеспечить совместное использование данных несколькими копиями приложения, как это подразумевается на рис. 12, то в самом приложении или в его менеджере данных должен быть предусмотрен механизм для исключения воздействий нескольких копий приложения друг на друга. Volume Manager и File System, компоненты пакета VERITAS SANPoint Foundation HA, предназначенные для работы в кластере, представляют собой один из таких механизмов. В последующих разделах рассматривается вопрос о совместном использовании данных в кластерах.

Модели данных кластера

Если ресурсы прикладного сервиса принадлежат к failover группе, то только серверу, на котором выполняется это приложение, предоставляется доступ к его данным. В случае отказа сервера и переноса выполнения этого приложения, управление его данными переходит к альтернативному серверу, но два или больше серверов никогда не получают доступ к одним и тем же данным одновременно. В сущности, многие технологии кластеризации не поддерживают одновременный доступ к данным. Для описания кластеров, в которых не поддерживается параллельный доступ к данным для нескольких серверов, часто используется термин «кластер без общих ресурсов» (shared-nothing cluster).

Недостатки кластеров без общих ресурсов

Возможности кластеров без общих ресурсов вполне достаточны для реализации переноса выполнения приложений с отказавшего на альтернативный сервер. Кроме того, как уже отмечалось выше, кластеры этого типа можно использовать для выполнения приложений, копиям которых не требуется одновременный доступ к одним и тем же данным (примером такого приложения является Web-сервис). Однако, существует гораздо более широкий класс приложений, которые обрабатывают транзакции посредством обновления файлов или баз данных. Поскольку эти приложения, в сущности, ведут записи, крайне важно, чтобы каждой копии такого приложения были доступны для чтения и записи одни и те же данные, благодаря чему все обновления немедленно становятся «видимыми» для любой из копий приложения. Для масштабирования подобных приложений с помощью кластерной технологии необходимо, чтобы кластер обеспечил нескольким серверам возможность одновременно монтировать одну и ту же файловую систему или открывать одну и ту же базу данных. Кроме того, необходимо, чтобы копии приложения, выполняемые на разных серверах такого кластера, могли читать и записывать данные в совместно используемой файловой системе или базе данных, но при этом была исключена возможность получения неправильных результатов из-за одновременного доступа нескольких копий приложения к этим данным.

Проблемы одновременного доступа к данным

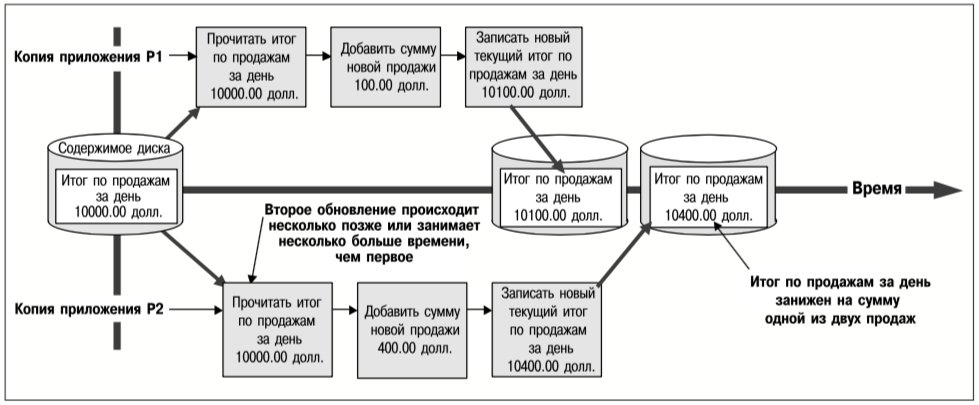

Некоординированный одновременный доступ к данным нескольких приложений может привести к различным видам искажения данных. Предположим, например, что приложение онлайновых продаж обновляет текущую итоговую сумму по операциям продаж за день. Всякий раз, когда осуществляется продажа, считывается текущий итог по продажам за день, к нему прибавляется сумма новой продажи и результат записывается обратно на устройство хранения данных. На рис. 13 представлен один из возможных сценариев, когда две и более копий этого приложения, работающих на разных серверах кластера, могут привести к искажению итоговой суммы продаж за день.

Проблема искажения данных, пример которой приведен на рис. 13, возникает из-за того, что копии приложения, запущенные на двух серверах, «не знают» о существовании друг друга. Когда копия P2 считывает итоговую сумму продаж за день, она не знает, что копия P1 уже прочитала это значение и поместила его в свой кэш с целью обновления. Чтобы обработка данных была корректной, последовательности операций чтение-изменение-перезапись, выполняемые каждой из копий приложения, должны быть неделимыми. Это означает, что каждая такая последовательность обновления должна выполняться как единое целое, т.е. во время ее выполнения над записью итоговой суммы по продажам за день не может быть выполнена ни одна не входящая в эту последовательность операция.

Если бы копии приложения, вносящие указанные изменения, выполнялись на одном и том же компьютере, то для корректной работы приложения потребовалась бы файловая система или СУБД, которые поддерживают одновременную работу нескольких программ записи. Такие менеджеры данных включают в себя менеджеры блокировок, которые временно запрещают доступ к группам байтов в файле или к записям в БД, чтобы предотвратить их одновременное обновление несколькими процессами.

Если процессы, представленные на рис. 13, выполняются на разных компьютерах, необходим распределенный менеджер блокировок. Тогда как локальный менеджер блокировок записывает информацию блокировки в структуры памяти, копии распределенного менеджера блокировок на каждом из совместно работающих компьютеров обмениваются между собой сообщениями о том, какие объекты данных заблокированы или разблокированы. Несколько копий файловой системы, работающих на отдельных компьютерах и использующих распределенный менеджер блокировок для координации обращений к данным, в совокупности называются распределенной или кластерной файловой системой. СУБД, подобные Oracle Parallel Server, поддерживают аналогичные функциональные возможности с помощью своих собственных распределенных менеджеров блокировок, специально предназначенных для блокировки объектов базы данных.

Управление данными с помощью пакета SANPoint Foundation HA

Volume Manager и File System, компоненты пакета VERITAS SANPoint Foundation HA, поддерживают одновременный доступ нескольких узлов кластера к объектам тома и файловой системы соответственно.

Еще раз об управлении томами

Как уже отмечалось раньше, том – это набор дисков под общим управлением, который файловыми системами и базами данных рассматривается как один или несколько дископодобных объектов, имеющих требуемые характеристики производительности ввода-вывода и доступности. Volume Manager выполняет две функции:

- Преобразует каждый запрос на чтение или запись данных тома в одну или несколько команд ввода-вывода диска, выдает эти команды и управляет результирующим потоком данных.

- Реализует алгоритмы зеркалирования или RAID-технологий, что позволяет защитить данные от потери при отказе диска.

Volume Manager не ограничивает доступ к области тома, содержащей пользовательские данные. Любому приложению или менеджеру данных, которые могут получить от операционной системы право на доступ к тому, разрешается считывать или записывать любой блок в области пользовательских данных этого тома. Собственно, Volume Manager обеспечивает сопровождение каждой операции записи на том всеми необходимыми командами ввода-вывода, чтобы поддержать отказоустойчивость тома (например, каждая запись данных на зеркалированный том преобразуется в команду записи на каждый из дисков тома), а также сохранить непротиворечивость состояния тома – составляющих его дисков или их частей.

Управление томами на одном сервере

В системе с единственным сервером через Volume Manager проходит каждый запрос на вводвывод и каждая операция управления. Это позволяет Volume Manager поддерживать целостность томов, например, путем обеспечения обработки запросов на чтение и запись в перекрывающиеся области блоков в таком порядке, который сохраняет дископодобную семантику. Приведем другой пример. Когда администратор дает команду увеличить объем тома, Volume Manager выделяет дополнительные устройства хранения и обновляет избыточные структуры данных на дисках, которые описывают том таким образом, что его можно восстановить после выхода системы из строя. Благодаря этому обеспечивается непротиворечивость тома в каждый момент выполнения команды его расширения.

Управление томами в кластерах

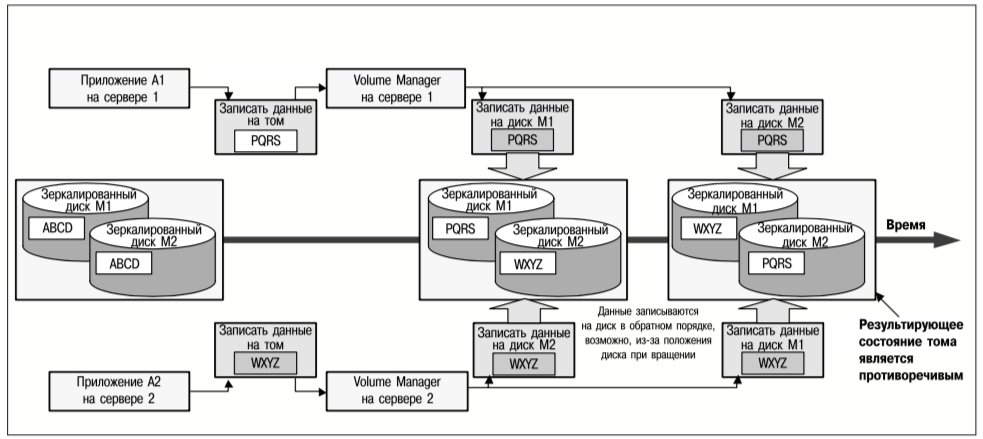

Когда том становится доступным для нескольких серверов, входящих в состав кластера, необходимо сохранить указанную непротиворечивость. Так, например, когда два приложения дают некоординированные команды записи данных на перекрывающиеся области блоков тома, любая из них может выполниться первой, как и в случае диска, но том должен всегда отражать результат операций записи, как это бы сделал диск. Недопустимо, чтобы зеркалированный том стал внутренне противоречивым из-за того, что операции записи на составляющие его диски выполняются в различном порядке, как показано на рис. 14.

На рис. 14 представлены операции записи данных двух приложений, запущенных на отдельных серверах кластера, в одну и ту же область блоков зеркалированного тома. Копия Volume Manager на каждом сервере преобразует команды записи на том в команды записи на каждый из составляющих его дисков. Если обе копии Volume Manager не будут координировать свои действия, то порядок выполнения команд записи на диск может привести к тому, что содержимое тома станет противоречивым.

Аналогично, если два сервера пытаются изменить конфигурацию тома (например, увеличить его объем), то необходимо тщательно координировать обновления метаданных на дисках, чтобы ситуации, подобные изображенным на рис. 13 и 14, не возникли с метаданными тома.

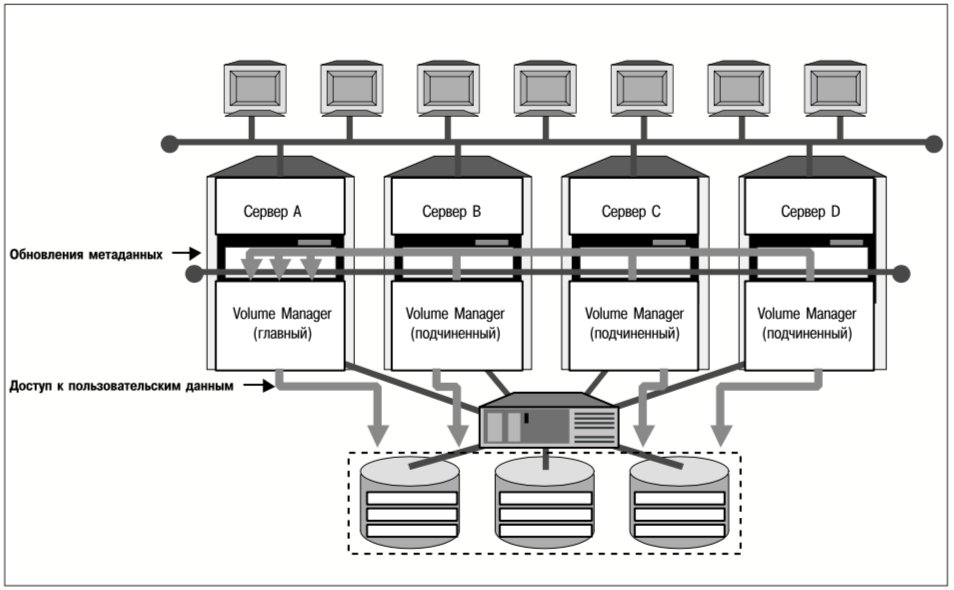

Volume Manager, входящий в состав пакета VERITAS SANPoint Foundation HA, использует архитектуру «главный-подчиненный» (master-slave) для решения указанной проблемы и обеспечения согласованного доступа к онлайн-томам для всех серверов кластера, как показано на рис. 15.

В кластере, где работает пакет SANPoint Foundation HA, один из серверов назначается главным для каждой из групп кластерных томов (набора дисков, управляемых Volume Manager как единое целое). Изменение метаданных тома можно инициировать с любого сервера, но все такие изменения выполняются копией Volume Manager на главном сервере соответствующей группы томов. Главный сервер блокирует доступ к группе томов всякий раз, когда необходимо обновить метаданные, поэтому все серверы из данного кластера обрабатывают запросы на доступ к пользовательским данным, всегда используя одинаковый образ метаданных тома.

Разумеется, главная копия Volume Manager может стать единственной точкой отказа, если сервер, на котором она запущена, выйдет из строя. Если это произойдет в кластере, где работает пакет SANPoint Foundation HA, то подчиненные копии Volume Manager согласуют между собой назначение нового главного сервера, и работа возобновится с меньшим количеством серверов. В настоящее время Volume Manager пакета SANPoint Foundation HA поддерживает до четырех серверов в кластере, а в будущем планируется реализация более крупных конфигураций.

Кластерная файловая система пакета SANPoint Foundation HA

Проблемы, связанные с доступом нескольких серверов к одной файловой системе, совершенно аналогичны проблемам диспетчера томов. Обновления метаданных необходимо координировать, чтобы все серверы из кластера имели непротиворечивое представление о файловой системе. При этом необходимо обеспечить семантику чтения и записи данных, как у файловой системы, на одном сервере. Подобно Volume Manager, программный продукт File System, входящий в состав пакета SANPoint Foundation HA, использует архитектуру «главныйподчиненный», обеспечивая непротиворечивое представление о файлах максимум для четырех кластерных серверов.

В типичной системе метаданные файловой системы изменяются гораздо чаще, чем метаданные тома. В кластере, где работает пакет SANPoint Foundation HA, приложения, выполняемые на любом сервере, могут создавать, расширять и удалять файлы и каталоги. Фактические обновления метаданных на дисках, представляющие собой выполнение указанных запросов, производятся главной копией File System. Все подчиненные копии File System используют внутренние кластерные соединения для передачи своих запросов на обновление метаданных главной копии, которая их и выполняет. Таким образом, гарантируется целостность метаданных файловой системы.

Файловые системы должны также воспроизводить дископодобную семантику при записи пользовательских данных. В кластерной среде это означает, что если одновременные запросы на запись данных, поступающие от двух серверов, изменяют перекрывающиеся области блоков, результат после их выполнения будет отражать запрос любого из серверов, но может не отражать некоторые части обоих запросов. Фактически это означает, что если сервер записывает данные в область блоков, она должна быть заблокирована на время выполнения операции записи. Пакет SANPoint Foundation HA включает в себя менеджер блокировок, который позволяет копиям File System, работающим на разных серверах, блокировать доступ к областям блоков тома, поэтому копии File System могут сохранять такую же семантику записи данных, как файловые системы на одном сервере.

Важное отличие файловой системы от диспетчера томов состоит в том, что в файловой системе производительность операций ввода-вывода частично обеспечивается за счет кэширования данных в памяти сервера; данные помещаются в кэш либо потому, что они могут потребоваться в будущем, либо просто для оптимизации выполнения операций ввода-вывода. В кластерной среде это создает проблему обеспечения согласованности – предоставление одного и того же образа данных файловой системы всем серверам кластера. Например, если в кэше сервера A имеется блок файловых данных, а сервер B обновляет этот блок на диске, то содержимое кэша сервера A становится недействительным. Сервер A должен каким-либо образом «узнать» о том, что если ему необходимо предоставить указанный блок данных приложению, то следует взять с диска новое содержимое блока, поскольку образ в кэше уже недействителен.

Для решения проблемы обеспечения согласованности кэша используется механизм менеджера блокировок пакета SANPoint Foundation HA. Когда один из серверов рассылает сообщение о своем намерении заблокировать какой-либо блок для обновления, другие серверы кластера, имеющие копии указанного блока в своем кэше, на основании этого сообщения признают свои копии недействительными и берут обновленные данные с диска, если необходимо предоставить их приложениям.

Важность кластеров серверов, совместно использующих данные

Диспетчеры томов и файловые системы, предназначенные для работы в кластере, значительно расширяют область применения кластерной технологии к проблемам информационных технологий (ИТ), для решения которых ресурсов одного сервера недостаточно. В принципе возможно реализовать параллельные прикладные сервисы без обеспечения доступа кластерных серверов к одним и тем же данным и устройствам их хранения. Однако, такие приложения либо по своей природе не должны требовать доступа к одним и тем же данным (например, Web-серверы «только для чтения»), либо должны быть разработаны так, чтобы каждая копия приложения обновляла свои собственные копии данных, причем действия приложений необходимо периодически согласовывать. Очевидно, что приложения «только для чтения» позволяют решить лишь ограниченный класс проблем, стоящих перед предприятием; а приложения, которые должны периодически согласовывать свои базы данных, по своей сути не являются постоянно доступными.

Предназначенные для работы в кластере диспетчеры томов и файловые системы, подобные тем, что входят в состав пакета SANPoint Foundation HA, решают указанную проблему. Эти компоненты дают возможность нескольким копиям приложения иметь одновременный доступ к одним и тем же объектам данных, что позволяет широкому классу традиционных приложений обработки транзакций, составляющих большинство средств обработки информации, работать на уровне производительности, превышающем производительность отдельного сервера.

Масштабируемость и доступность

Кроме того, кластер, позволяющий масштабировать приложения посредством выполнения нескольких их копий на разных серверах, можно сконфигурировать таким образом, чтобы обеспечить высокую доступность этих приложений. Хотя группы параллельных ресурсов не перезапускаются на альтернативных серверах подобно failover группам ресурсов, постоянный доступ приложений можно обеспечить просто посредством перенаправления клиентских запросов на альтернативную копию приложения. Клиентские запросы часто направляются аппаратными или программными средствами распределения нагрузки, такими, как Network Load Balancer (NLB) компании Microsoft для Windows-серверов или маршрутизатор распределения нагрузки Local Director компании Cisco. Если средство распределения нагрузки установлено, в случае отказа одного из серверов приложений клиентские запросы распределяются между остальными серверами кластера.

Кластеры и сети хранения данных

Как уже отмечалось выше, кластеры являются наиболее гибкими и управляемыми в том случае, если их устройства хранения подключены к сети хранения данных (SAN), которая обеспечивает полносвязное и прямое соединение устройств хранения данных с серверами, входящими в кластер. Соединяя все серверы кластера со всеми устройствами хранения данных, SAN повышает гибкость кластеров, позволяет реализовать параллельное выполнение групп прикладных сервисов и делает возможным каскадный перенос выполнения приложений на альтернативные серверы в случае отказа (см. выше) для обеспечения их сверхвысокой доступности.

Возможности SAN

На многих предприятиях SAN охватывает все устройства хранения, имеющиеся в центре обработки данных. В таких центрах несколько кластеров серверов можно подключить к общему пулу устройств хранения данных. На рис. 16 представлен центр обработки данных, в котором кластеры P и Q, включающие в себя по два сервера, соединены с общим пулом устройств хранения данных, через SAN.

Возможность установить соединения между всеми устройствами хранения в центре обработки данных позволяет с помощью простых операций управления использовать ресурсы устройств хранения данных в любом месте, где они необходимы. Когда все устройства хранения физически соединены со всеми серверами, имеющимися в центре обработки данных, избыточную емкость запоминающих устройств на одном сервере или в одном кластере можно предоставить для использования другому серверу или кластеру, не проводя физического реконфигурирования устройств. Большинство операционных систем поддерживают такое перемещение и в тех случаях, когда соответствующие серверы находятся в режиме онлайн, т.е. для использования только что выделенных ресурсов не требуется перезагрузка серверов. Вместо применения пула устройств хранения данных переполнения (an overflow storage pool) для каждого сервера, который позволяет удовлетворить экстренные потребности сервера в дисковой памяти, можно использовать единый пул, который способен удовлетворить потребности целого центра обработки данных. Чем больше центр обработки данных, тем больше экономия ресурсов.

Технические проблемы SAN

Хотя SAN значительно повышает гибкость устройств хранения данных и позволяет существенно сократить капитальные затраты, для использования её возможностей в полном объеме необходимо решить определенные технические проблемы. В современных концепциях разработки операционных систем устройства хранения рассматриваются как «легко обнаруживаемые» периферийные устройства, управляемые сервером, к которому они подключены. Реализация в современных операционных системах таких принципов, как:

- сетеподобное соединение устройств хранения данных, при котором огромное адресное пространство делает задачу обнаружения устройств хранения нетривиальной для операционных систем;

- динамический переход управления устройствами хранения от одного сервера к другому в большинстве случаев является достаточно сложной задачей.

Управление SAN

К настоящему времени разработчики и производители устройств хранения данных и средств для объединения их в сеть нашли решение проблем, связанных с обнаружением устройств хранения и управлением ими. Разработчики подсистем хранения данных обеспечивают в своих продуктах возможность маскирования логических номеров устройств (LUN), что позволяет связать диски и массивы с путя-

ми доступа к конкретным серверам. Разработчики инфраструктуры SAN встраивают в свои продукты средства разбиения SAN на «зоны», что предотвращает получение доступа к устройствам хранения одного сервера или кластера другим сервером. Операции управления позволяют изменить связи между устройствами хранения и серверами, а также перемещать устройства из одной зоны в другую.

Ограничения покомпонентного управления SAN

Средства управления компонентами SAN позволяют в определенной мере реализовать потенциальные возможности SAN, но у таких средств имеется следующий недостаток: поскольку они разрабатываются и предоставляются производителями компонентов, то, как правило, предназначены для компонентов, выпускаемых именно этим производителем. Так, средства управления от производителя коммутаторов стандарта Fibre Channel обычно позволяют управлять коммутаторами только этого производителя, но не другими устройствами такого типа. Эта ситуация противоречит современной открытой концепции разработки технологии SAN.

Еще один недостаток – пользовательские интерфейсы, которыми каждый производитель комплектует свои средства управления компонентами SAN. Хотя такие интерфейсы, как правило, оптимальны для конкретных продуктов данного поставщика, с точки зрения пользователя каждый дополнительный интерфейс для управления компонентами означает, что необходимо установить, освоить и поддерживать еще один программный продукт. Пользователи заинтересованы в том, чтобы отдельных средств управления компонентами было как можно меньше, и чтобы они были единообразными.

Программный пакет VERITAS SANPoint Control

Приняв во внимание возможности, которые открывает использование SAN в крупных центрах обработки данных, компания VERITAS разработала архитектуру «шина управления» («management bus»), позволяющую управлять разнообразными компонентами SAN с помощью ряда средств управления. Такая архитектура лежит в основе программного продукта VERITAS SANPoint Control, который представляет собой пакет средств управления SAN. В настоящее время в пакет SANPoint Control включены средства для обнаружения устройств хранения данных и адаптеров, а также для разбиения SAN на зоны. Перечисленные средства предназначены для инфраструктур SAN, состоящих из соединенных между собой коммутаторов, выпущенных любым крупным производителем этого аппаратного обеспечения. FC-адаптеры и RAIDмассивы в ближайшем будущем тоже войдут в число элементов SAN, которыми можно управлять с помощью пакета SANPoint Control.

Пакет SANPoint Control включает в себя абстрактные модели для каждого типа управляемых им устройств. Эти модели адаптируются в соответствии с возможностями конкретных устройств; адаптацию выполняют программные модули, называемые провайдерами (providers), которые устанавливают соответствие между функциональностью для управления устройствами и абстрактными моделями SANPoint Control. Провайдеры реализуются компанией VERITAS самостоятельно или при участии производителей компонентов SAN, что позволяет максимально ускорить выпуск на рынок этих программных модулей и максимально расширить круг адаптируемых ими устройств.

Глобальные кластеры и восстановление после аварий

Электронный бизнес приобретает глобальный характер в своей сфере деятельности гораздо быстрее, чем традиционный. По мере глобализации бизнеса задача обеспечения постоянной доступности становится еще более сложной:

- Высокая доступность приложений, которую обеспечивают кластеры, недостаточна: в случае аварии масштаба предприятия и выхода из строя целого кластера высока вероятность того, что окажется невозможным восстановить функционирование предприятия электронного бизнеса.

- Если на предприятии вся деятельность по обработке данных сосредоточена в единственном центре обработки данных, то некоторые из клиентов такого предприятия неизбежно окажутся «далеко» от приложений в смысле времени прохождения сообщений, что приведет к увеличению времени отклика на запросы подобных клиентов и уязвимости предприятия перед «локальными» конкурентами.

- Управление глобальными процессами обработки информации может стать чрезмерно дорогостоящим, а в быстро изменяющейся среде электронного бизнеса – совершенно невозможным.

Управление глобальными кластерами

Компания VERITAS объединила технологию кластеризации VCS, средства репликации данных и мощный инструментарий управления в программном продукте Global Cluster Manager (GCM), который позволяет решить перечисленные выше проблемы глобальной обработки информации.

GCM группирует кластеры VCS в сайты (sites) и устанавливает связи между ними с помощью средств администрирования, в результате создается глобальный вычислительный ресурс, управляемый из единого центра. GCM состоит из следующих компонентов:

- Механизм определения кластерных событий, которые автоматически инициируют заданную политику глобального управления, например, перемещение выполнения группы прикладных сервисов с одного кластера на другой в случае аварии.

- Гибкая схема проверки состояния, позволяющая администраторам использовать встроенный механизм обмена контрольными сообщениями для проверки состояния системы или определять собственные механизмы обмена сообщениями, которые лучше соответствуют различным конфигурациям и приложениям.

- Агент сервера доменных имен (DNS), который позволяет установить соответствие между символическими сетевыми именами и IP-адресами в различных подсетях, что обеспечивает возможность глобального переноса выполнения сервисов на другие серверы в случае отказа.

- Интерфейс управления на основе Web-навигатора, который позволяет осуществлять глобальное управление системой из любой точки сети.

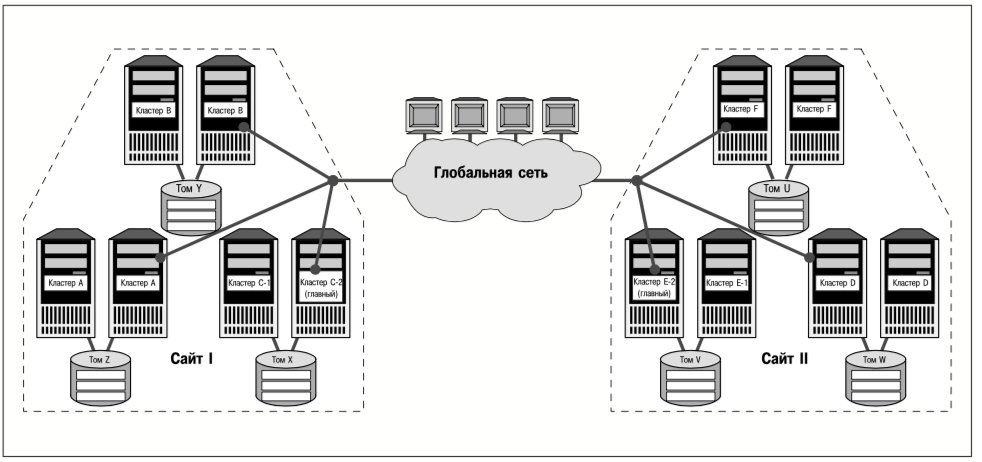

На рис. 17 изображены два сайта, обозначенные как Сайт I и Сайт II. Сайт GCM представляет собой набор соединенных между собой кластеров, причем по крайней мере один из этих кластеров является для данного сайта главным (site master); весь набор кластеров (сайт) подключен к остальной части глобальной системы кластеров. Программное обеспечение главного кластера сайта GCM можно сконфигурировать как группу прикладных сервисов VCS таким образом, чтобы отказы серверов обнаруживались и обрабатывались локально с помощью средств, предусмотренных в VCS. На рис. 17 сервер C-2 кластера C является главным для Сайта I, а сервер E-2 – главным для Сайта II. В глобальной системе кластеров информация о VCS-копиях на сайте передается через главный сервер.