Мёд – это очень уж странный предмет. Всякая вещь – или есть, или нет, А мёд (я никак не пойму, в чём секрет!), Мёд если есть, то его сразу нет!

Мультфильм «Винни-Пух», 1972 г.

Представим ситуацию: небольшая команда разработчиков-энтузиастов в свободное от работы время написала прикладную программу и выложила ее код в открытый доступ на всеобщее обозрение. Вы как владелец бизнеса заинтересовались этим ПО с точки зрения его применимости для решения конкретной задачи. Но вот беда – в своем исходном виде оно мало подходит именно под ваши бизнес-потребности и не встраивается должным образом в ИТ-ландшафт. Подобное встречается с завидной регулярностью. Тогда вы нанимаете «свободных художников» – авторов Open Source ПО – для его кастомизации. И, по сути, воспроизводите модель работы отдела автоматизации на любом более-менее крупном предприятии Советского Союза.

Общераспространенная тогда in-house разработка – собственные бухгалтерские программы, системы управления производством и т.д. – гарантировала прямо-таки тотальную кастомизацию решений и в то же время исключала возможность их использования в другой организации. Точно так же и сейчас открытое ПО, которое максимально «затачивается» под потребности компании, теряет одно из главных своих свойств – общеупотребимость. И отчасти перестает быть Open Source. То есть «мед если есть, то его сразу нет». Вполне возможен и другой вариант – разработчики принципиально откажутся дорабатывать свое детище под ваши потребности. Либо вы изыщете другие человеческие ресурсы под эту задачу, либо польза от конкретно этого «открытого» ПО сразу сведется к нулю.

Есть ещё один аспект разработки ПО, о котором редко кто задумывается. Как разрабатывает ПО вендор проприетарного (лицензируемого) софта? Так, чтобы сократить свои расходы на поддержку – ведь покупное ПО в большинстве своем приобретается с поддержкой. И при разработке тщательно отслеживаются рамки возможной кастомизации «в поле». В результате даже при больших возможностях настройки заказчик никогда не выходит (просто не может) за рамки стандартной поддерживаемой системы. А чем с точки зрения последующей поддержки руководствуются создатели открытого ПО? У каждого свое видение на этот счет.

Стоит сказать пару слов о том, как участники Open Source Community воспринимают ИТ-ландшафт компании. Вернее сказать, зачастую они не воспринимают его как единое целое, у них отсутствует концептуальное представление об архитектуре больших систем. В силу этого их ПО, достойное само по себе, не согласуется с другими составляющими ИТ-инфраструктуры – за деревьями не видно леса.

Open Source как необходимость

Лучший подарок, по-моему, мед! Это и ослик сразу поймет. Даже немножечко, чайная ложечка, Это уже хорошо, Ну а тем более полный горшок!

До этого мы говорили об открытом ПО с точки зрения изначально заложенных в нем ограничителей использования. Считайте это нашим ответом на соблазн воспринять эту концепцию как панацею от всех возможных ИТ-проблем. Теперь рассмотрим ситуации, когда Open Source действительно незаменим, формат, в котором «открытость» начинает приносить пользу, и факторы, обусловливающие необходимость этих решений. Теперь разговор пойдет в более прагматичном ключе.

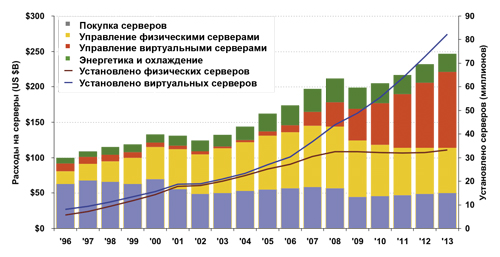

За последние 15 лет структура ИТ в крупных корпорациях существенно изменилась. И причина этого кроется в появлении принципиально новой бизнес-концепции – глобального интернет-бизнеса. Традиционный принцип построения ИТ-инфраструктуры подразумевает наличие относительно небольшого числа высокопроизводительных, вертикально масштабируемых ИТ-решений «под лицензиями». Google, Amazon, Facebook и другим гигантам рынка такой вариант не подходит по определению. В силу специфики им нужны многие тысячи стандартных, взаимозаменяемых, можно сказать, примитивных серверов и ПО либо собственной разработки, либо разработанное на базе Open Source. Иначе просто денег не напасешься на лицензии. Соответственно, в их дата-центрах превалирует принцип горизонтального, а не вертикального масштабирования. Затраты на ИТ также смещаются – OPEX (расходы на электроэнергию, техобслуживание ЦОД, обслуживающий персонал и т.д.) превышает CAPEX (см. рис. 1). Каков объем этого новообразовавшегося рынка? Аналитики IBM приводят цифры: 10 крупнейших хостинг-провайдеров сегодня «потребляют» около 20% от общего числа производимых в мире серверных процессоров.

Таким образом, корпорации заинтересованы в появлении реальных альтернатив закрытым проприетарным решениям, созданным в стенах одной компании-производителя. По сути единственную альтернативу предлагает альянс OpenPOWER Foundation, основанный IBM, Google, NVIDIA, Mellanox Technologies и TYAN Computer в 2013 году. В его основе лежит идея раскрытия процессорной архитектуры Power от IBM для использования другими производителями оборудования. Речь идет о предоставлении конструкции серверов Power и ПО с открытым кодом, в том числе BIOS и системы виртуализации, партнерам (Google, Tyan и др.), чтобы они могли создавать собственные системы. Кроме того, другие компании могут разрабатывать собственные процессоры на основе базовой конструкции. На настоящий момент в альянс входят уже более 120 компаний.

В чем Power, брат?

Конец твоим страданьям и разочарованьям, И сразу наступает хорошая погода! Когда тебе или ему, когда ну все равно кому Подарят в день рождения горшок из мёда!

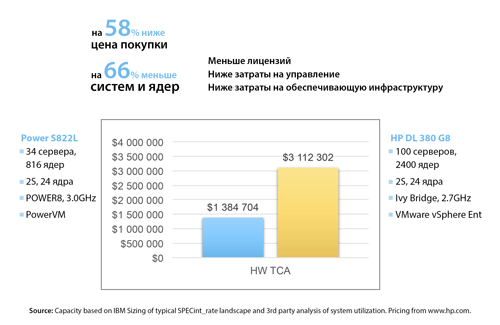

Около года назад IBM представила новый процессор Power8 и первые серверы нижнего уровня на его основе, предназначенные для систем с горизонтальным масштабированием – cloud-сред и серверных ферм. Если сравнивать его с другой распространенной архитектурой – x86 от Intel, можно отметить более высокую производительность Power8. По всем индустриальным бенчмаркам ядро POWER имеет, как минимум, двойное преимущество в производительности по сравнению с х86. А если учесть, что серверы х86 крайне редко бывают загружены хотя бы на 50%, а для POWER IBM дает гарантию неухудшения эксплуатационных характеристик при загрузке как минимум 65%, мы получаем пропорцию 1 к 3. Соответственно, 30 серверов на процессоре Power8 начального уровня делают работу, эквивалентную 100 серверам х86 такого же уровня. Как минимум 100. Отметим, что стоимость Power8 при долгосрочном использовании (в перспективе нескольких лет) примерно в 2 раза ниже, чем x86 (см. рис. 2).

Экстраполируйте эти цифры на реальный ЦОД, и вы получите значительную экономию – до 70% – занимаемого оборудованием места, электроэнергии, затрат на обслуживание, управление и т.д. Для того же Google, ИТ-хозяйство которого, по мнению экспертов, насчитывает более 2 миллионов серверов, это снижение OPEX на многие десятки миллионов долларов в год.

Коротко и емко скажем об основных технических характеристиках решения. Высокая производительность процессора достигается за счет наличия в нем 12 ядер (для сравнения в предыдущей версии – Power7 – их было в полтора раза меньше) и их более высокой – как минимум вдвое – производительности по сравнению с лучшими представителями семейства х86. Повышение пропускной способности для задач, требовательных к скорости обмена с памятью, обеспечивает расширенный размер кэша. Для оптимизации работы с памятью предназначена интеллектуальная новинка – чип буфера ОЗУ, который управляет обменом с ОЗУ в зависимости от приоритета задачи.

Особого внимания заслуживает интерфейс CAPI (Coherence Accelerator Processor Interface), предназначенный для согласованного подключения ускорителей. Современные системы много времени тратят на мелкие повторяющиеся операции, такие как компрессия, шифрование и т. д., используя для этого универсальный процессор. IBM решила предоставить таким задачам спецпроцессоры и для этого дала разработчикам таких ускорителей прямой доступ в оперативную память. Это открывает новые возможности для интеграции оборудования.

На последнем моменте стоит остановиться более подробно. Развитие платформы Power в первую очередь подразумевает выстраивание вокруг нее обширной экосистемы «дочерних» программных и аппаратных продуктов других производителей. Проще говоря, IBM в альянсе производит только процессор, NVIDIA адаптирует под него микрокод своего графического ускорителя, Mellanox Technologies – адаптер ввода/вывода, и т.д. Для этого компании-партнеры имеют в своем распоряжении исходный код промежуточного ПО, которое управляет базовыми функциями Power. Наличие подобной экосистемы позволяет создавать различные настройки и сценарии работы серверов при разных нагрузках и в разных областях применения. Так, графические ускорители NVIDIA, «заточенные» именно под Power, в связке с ним показывают 2–3-кратное уменьшение задержек. Физически ускорители те же самые, но их научили использовать все преимущества процессора Power8, что стало возможно только благодаря открытой архитектуре.

Другой пример: на первом OpenPOWER Summit, состоявшемся в марте этого года, один из участников консорциума – компания Algo-Logic Systems – представил специализированное решение по ведению книги брокерских заявок (используется на биржах). Оно базируется на гибриде Power8 и спецпроцессора и позволяет ускорить прохождение брокерских заявок в десятки, а то и в сотни раз по сравнению с текущей ситуацией – до 230 наносекунд. При этом все компоненты решения стандартны и заимствованы у других участников консорциума, added value дает именно их подогнанность друг под друга.

IBM также готова передать партнерам чертежи, лицензии на Power и помочь организовать производство этих процессоров. Несколько китайских компаний-участников Open Power уже начали выпуск собственных серверов на базе Power8. По факту это полностью китайские «машины» с китайскими процессорами, обеспечивающие технологическую независимость от западных производителей.

Последний озвученный нами фактор особенно актуален для нашей страны в контексте политики импортозамещения. На российском корпоративном поле разработки, основанные на Open Source подходе, можно сказать, обречены на большие перспективы. Во-первых, отечественных проприетарных решений на рынке буквально единицы: из крупного и качественного – несколько процессинговых, банковских систем, систем электронного документооборота, ИБ-продуктов. То есть многие ниши свободны, уровень конкуренции в них стремится к нулю. Во-вторых, Open Source позволяет избежать запретов, которые потенциально (а главное внезапно) могут налагаться зарубежными производителями.

Итак, концепция Open Source будет только прогрессировать, поскольку она необходима в новых реалиях. Мы понимаем под ней совместную работу сообщества ведущих производителей аппаратного и программного обеспечения над созданием корпоративных решений на базе открытого исходного кода. Для бизнеса это возможность использовать экосистему взаимодополняющих друг друга продуктов, способную более эффективно решать его задачи.

Подписаться

Подписаться Читать в телеграм

Читать в телеграм